Alain Bouquet - Le programme Manhattan

6 - Los ALamos

<Attention: ces pages ne sont plus mises à jour car le site a déménagé. Il se trouve désormais à: Pensez à mettre à jour vos signets et bookmarks! |

Champs, Noyaux & particules

Radioactivité

Noyaux, protons et neutrons

- Noyau atomique: Rutherford

- Noyau atomique: Bohr, Soddy et Moseley

- Noyau atomique: Aston et Rutherford

- Neutron: Chadwick

- Neutron: Joliot-Curie

- Neutron: Fermi

Intruments, accélérateurs et détecteurs

Mécanique quantique

- Mécanique ondulatoire

- Formalisme quantique

- Applications

- Théorie quantique des champs

- Électrodynamique quantique

Fission nucléaire

Fusion nucléaire

Particules en tout genre

- Los Alamos, ville secrète

- Organisation du laboratoire

- Premiers travaux

- Calcul numérique

- Crise de l'été 1944 et réorganisation

- Little Boy

- Fat Man

- LoPo et HyPo : réacteurs expérimentaux

- Effets d'une explosion nucléaire

- La première explosion nucléaire: Trinity

LOS ALAMOS LA VILLE SECRÈTE

Sélection du site

Oppenheimer et Groves avaient eux-mêmes choisi le 16 novembre 1942 d’installer le site Y à Los Alamos, à l’emplacement d’un pensionnat de garçons, le Los Alamos Ranch School (qui eut William Burroughs et Gore Vidal parmi ses élèves) dont les bâtiments formèrent le noyau initial du laboratoire. Situé au Nouveau Mexique, à une cinquantaine de km au nord-ouest de Santa Fe, le site était d’un accès difficile. Il occupait à 2250 m d’altitude une partie du flanc Est d’une ancienne caldeira (les monts Jemez dont le volcan est éteint depuis plusieurs millions d’années), creusée par l’érosion de profonds canyons séparés par des plateaux (mesas) boisés (« los alamos » signifie « les peupliers »). À l’ouest s’élève la montagne de Pajarito, à l’est les sommets de la chaîne du Sangre de Christo (rouges au crépuscule). L’altitude compense en partie le climat désertique, les températures descendant à -10°C en hiver et montant en moyenne à 30°C l’été dans la journée, mais les nuits sont fraîches. L’été est aussi la saison la plus humide avec de violents orages.

Une mesa vue de Los Alamos, avec les montagnes Sangre de Christo à l’arrière-plan.

La capitale de l’État du Nouveau-Mexique, Santa Fe se situe à 50 km au sud-est (à 2100 m d’altitude, c’est la plus haute des capitales d’État aux États-Unis). L’architecture suit un style néo-colonial espagnol (dit Pueblo Revival) donnant à la région un caractère original (la ville se proclame « The City Different »). La principale ville de l’État, Albuquerque, sur les bords du Rio Grande, se trouve à 90 km au sud. Sa population ne dépassait pas 6 000 habitants en 1900 mais elle atteignait déjà 35 000 habitants en 1940 (100 000 en 1950, 520 000 aujourd’hui), en faisant une des villes croissant le plus vite dans le pays. Le climat est similaire à celui de Santa Fe, l’altitude de la ville variant de 1500 à 2000 m.

La région de Los Alamos, avec les villes de Santa Fe à 50 km au sud-est et Albuquerque à 90 km au sud ©GoogleMaps

La région de Los Alamos : un plateau boisé entaillées par des gorges profondes

Le projet initial d’Oppenheimer n’imaginait qu’un petit laboratoire de recherche sur la physique des neutrons rapides, et Manley avait esquissé un laboratoire d’une cinquantaine de personnes, rassemblant les différentes équipes alors actives : une douzaine de théoriciens et une trentaine d’expérimentateurs (assistants compris), et un secrétariat de cinq personnes. Groves, lui, envisagea immédiatement un établissement d’une ampleur plus grande, rassemblant quelques centaines de scientifiques et de techniciens autour de la conception et de la réalisation d’une arme. La réalisation des installations fut confiée le 6 décembre à la compagnie M.M. Sundt (et/ou l’Engineering District d’Albuquerque ?) qui commença immédiatement les constructions (sans plans). Dès mars 1943, les premiers bâtiments étaient achevés, Oppenheimer s’installa le 15 mars. Physiciens et techniciens arrivèrent progressivement dès avril 1943. Le 20 avril, un accord fut passé avec l’université de Californie pour qu’elle gère tous les contrats du personnel (accord toujours en vigueur : le Los Alamos National Laboratory est généré par l’Université de Californie, tout comme le Lawrence Livermore National Laboratory). Fin avril, le projet initial était réalisé à 95%, mais il se révéla immédiatement beaucoup trop petit.

À Los Alamos, la « Big House », reste de la Los Alamos Ranch School, fut le coeur de l'activité sociale pendant les années de guerre et d’isolement © Wikipedia

De même que Fuller Lodge

Entretemps, Oppenheimer avait pris son bâton de pèlerin pour convaincre les plus brillants de ses collègues d’abandonner ce qu’ils faisaient pour aller s’enterrer dans un endroit perdu du Nouveau Mexique et y travailler sur un projet militaire secret sur lequel il n’avait pas le droit de leur donner de détails. Complication supplémentaire, la plupart des meilleurs physiciens américains se trouvaient déjà impliqués dans des programmes prioritaires, à commencer par le radar, et le NDRC refusaient qu’ils soient affectés à d’autres projets. Parce qu’ils ne souhaitaient pas voir couronner trois siècles de science par une arme effroyable, Lise Meitner, Franco Rasetti à Montréal, et Isidor Isaac Rabi (alors directeur scientifique du Rad Lab au MIT) furent presque les seuls à refuser (à contrecœur, Rabi accepta cependant de venir de temps à autre comme consultant à Los Alamos, et il était présent lors de l’essai Trinity). Condon démissionna dès la 26 avril 1943 de ses fonctions de directeur adjoint, en complet désaccord sur les mesures de sécurité imposées par les militaires. Il estimait que le cloisonnement exigé par Groves empêchait la coordination indispensable entre les savants, bridait le programme et freinait son exécution. Mais la plupart acceptèrent l’offre d’Oppenheimer car, comme Oppenheimer le dit lui-même plus tard (en parlant alors de la bombe H), « It was technically sweet ». L’éventail des problèmes techniques et scientifiques qui se posaient à eux était trop séduisant.

De plus, Oppenheimer parvint à éviter que Los Alamos soit militarisé, bien que dans un premier temps Groves ait voulu attribuer des grades militaires aux physiciens selon leur rang (Oppenheimer eût été lieutenant-colonel !) et les astreindre à une discipline militaire. Oppenheimer n’était pas contre, initialement, mais il recula devant le tollé. Un compromis fut trouvé : Los Alamos fonctionnerait pendant les premiers mois de mise en route comme un laboratoire universitaire classique, avec un statut civil pour le personnel garde au moins, puis serait progressivement militarisé. Mais cela ne fut en fin de compte jamais mis en œuvre pour les scientifiques. Par contre les nombreux militaires présents, en particuliers les techniciens incorporés dans l’armée (les SED) furent eux-soumis à une discipline militaire, d’où des tensions entre les deux communautés. Les scientifiques conservèrent l’entière direction des recherches, l’armée se limitant à assurer l’intendance et la sécurité du site (parfois de manière excessivement tatillonne, et Feynman prit un grand plaisir à déjouer les contrôles).

Les physiciens purent également faire venir leurs familles. La vie à Los Alamos était malgré tout matériellement difficile et très confinée, et plusieurs ne le supportèrent pas. Certains parvinrent à ne venir à Los Alamos que pour des périodes assez courtes, en tant que consultants et en retournant le plus possible dans leurs laboratoires : von Neumann, par exemple, ou Bohr (quand il parvint à s’échapper du Danemark) ne firent que de brefs séjours, en général pour débloquer une situation.

La maison occupée par Oppenheimer à Los Alamos

Le rôle essentiel d’Oppenheimer fut d’assurer la coordination et l’arbitrage entre les différentes divisions en charge respectivement des aspects théoriques de la conception de l’arme, des aspects nucléaires expérimentaux, des essais de configuration d’explosifs, des essais d’aérodynamique de la bombe, des techniques métallurgiques de fabrication, etc. Il avait réussi à rassembler tellement de « stars » à Los Alamos que les questions d’ego devinrent également très vite cruciales. Des rivalités féroces se firent jour. Edward Teller pensait que le rôle de directeur de la Division de Théorie aurait dû lui revenir et, supportant très mal d’être sous la coupe de Hans Bethe, préféra travailler sur la fusion plutôt que d’exécuter sa part des travaux théoriques sur la fission. Edward Condon ne supporta la tutelle étroite des militaires que quelques semaines avant de démissionner. Oppenheimer, comme le raconte Teller, finit par connaître personnellement plusieurs centaines des personnes qui travaillaient à Los Alamos, non seulement leur travail mais aussi leur histoire personnelle, leur situation de famille, et leurs relations avec leurs collègues. Il parvenait également à suivre les dizaines de recherches simultanément menées par les divers groupes et son extraordinaire capacité de synthèse lui permit de conserver une vue d’ensemble du programme sans jamais perdre l’objectif de vue.

La vie à Los Alamos, ou Boîte postale 1663 à Santa Fe

Le site se transforma en un immense chantier, et ne cessa pas de l’être pendant toute la durée de la guerre, de nouvelles constructions étant ajoutées au fur et à mesure des besoins. Il s’agit le plus souvent de constructions légères, généralement en bois, et des appartements (4 sur deux niveaux par maison) pour les familles, des dortoirs pour les célibataires, une pharmacie et une infirmerie de six lits (vite agrandie en hôpital dont le personnel dépassa la centaine à la fin de 1944), un cinéma, une bibliothèque et bien sûr des bureaux, des ateliers, des halls de montage, et des laboratoires. En 1945, 7 000 personnes vivaient et travaillaient à Los Alamos.

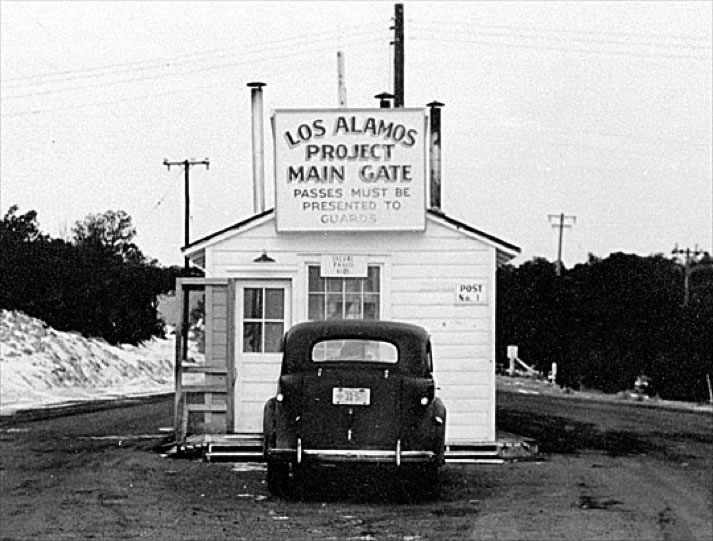

L’entrée principale de la zone enclose, en 1943

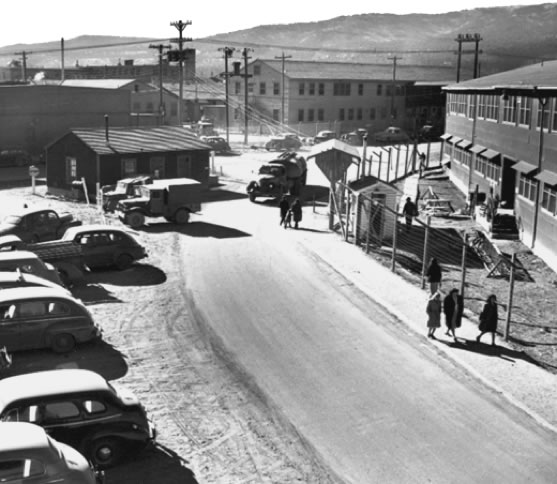

West Road à Los Alamos en 1944

Trinity Drive, avec le passage surélevé reliant les laboratoires© LAHS

Zone résidentielle à Los Alamos à l’époque d’Oppenheimer ©LANL

La vie n’était pas très facile à Los Alamos, surtout la première année où bien des équipements manquaient. Le Nouveau Mexique est une région aride, même si la mesa était boisée, et le vent sec et chaud desséchait la terre et les résidents. Les risques d’incendie étaient importants, surtout avec des constructions en bois, et l’eau était rare (il existait bien un petit étang, l’Ashley Pond, du nom du précédent propriétaire Ashley Pond II, mais il n’aurait jamais suffi à la consommation d’eau et des conduites durent être posées sur des dizaines de kilomètres). L’isolement imposait aussi de pénibles contraintes, réduisant presque à zéro les contacts avec familles et amis à l’extérieur, le courrier était censuré et passait toujours par la boîte postale 1663 à Santa Fe. Les déplacements en dehors du site strictement interdits sauf autorisation spéciale, en dehors de balades à pied le dimanche dans les montagnes de Jemez ou de pique-niques dans les canyons environnants. L’interdiction fut allégée à l’automne 1944, et des excursions à Santa Fe, Albuquerque ou dans les montagnes du Sangre de Christo furent permises (si l’on trouvait un véhicule, de l’essence et des pneus !). Il y avait très peu de téléphones, uniquement dans les bureaux au début, puis quelques uns furent installés dans la « ville » pour les appels d’urgence (mais passant par le standard militaire).

La maison des Teller à Los Alamos.

À droite, mais bien après la guerre, Edward Teller (à droite) jouant aux échecs avec son fils Paul, arrivé à Los Alamos à l’âge de deux mois, sous le regard de sa femme Mici et de sa fille Wendy © Lawrence Livermore Laboratory

Il y avait peu de femmes physiciennes. Maria Goeppert-Mayer, auparavant à Columbia au « Department of Substitute Materials », travailla sur des questions d’opacité pour Teller en 1945 (mais en restant à Columbia ?). Mary Langs et son mari Harold Argo étaient des étudiants de Teller à George Washington, et ils le suivirent en 1944 à Los Alamos : ils travaillèrent sur les réactions de fusion D-D et D-T pour la « Super » jusqu’après la guerre (ils partirent avec lui à Chicago, logeant chez Maria Goeppert-Mayer). Joan Hinton, nièce de Geoffrey Ingram Taylor, le spécialiste britannique de la mécanique des fluides, rejoignit Los Alamos en février 1944 pour travailler avec Fermi sur la réalisation des réacteurs à uranium enrichi (les « water boilers »). Les bombardements d’Hiroshima et Nagasaki la conduisirent à militer contre les armes nucléaires, puis à s’exiler en Chine communiste en 1948.

Le « commissary » à Los Alamos, ancêtre des supermarchés

Elizabeth "Diz" Riddle Graves avait passé sa thèse à Chicago sur la diffusion des neutrons, travaillé au Met Lab, et vint à Los Alamos (où elle passa d’ailleurs le reste de sa carrière) travailler sur le réflecteur à neutrons des bombes. Son mari Alvin C. Graves était aussi physicien et se trouvait à côté de Louis Slotin lors de l’accident mortel de ce dernier en 1946. Il y eut plusieurs mathématiciennes (Mici Teller, Frances Wilson Kurath), et beaucoup de jeunes femmes travaillèrent à la division T-5 comme calculatrices.

Plusieurs épouses de physiciens occupèrent des fonctions importantes, en général administratives, aux côtés de Priscilla Greene, la secrétaire particulière d’Oppenheimer (elle avait quitté ses fonctions près de Lawrence à Berkeley par enthousiasme pour le projet), Charlotte Serber fut la bibliothécaire scientifique. De nombreux physiciens, ingénieurs et techniciens, amenèrent femmes et enfants souvent très jeunes. L’armée avait aussi détaché plusieurs auxiliaires féminines (WACs), qui ne furent pas toujours ravies de se retrouver sur un haut plateau semi-désertique au lieu des îles du Pacifique escomptées. Devant le manque de techniciens qualifiés et d’ingénieurs, l’armée détacha également des étudiants en ingénierie incorporés (le Special Engeneer Detachment ou SED). Malgré parfois quelques tensions, la cohabitation entre civils et personnels en uniforme se passa sans trop de heurts, malgré des écarts importants de solde, l’interdiction faite aux militaires de faire venir leur famille, et des obligations disciplinaires différentes. Plusieurs officiers, de l’Armée et de la Marine, furent aussi affectés à Los Alamos. En septembre 1943, il y avait une soixantaine de femmes travaillant dans la zone technique, et environ 180 un an plus tard, dont une vingtaine de scientifiques, une cinquantaine de techniciennes, une quinzaine d’infirmières, vingt-cinq enseignantes et soixante-dix secrétaires. Les scientifiques et les techniciennes se répartissaient dans les différentes groupes (16 dans la division de théorie, 4 dans celle de physique expérimentale, 25 dans celle de chimie-métallurgie, 20 dans celle de l’ingénierie des bombes, et 12 dans celle des explosifs).

Des militaires au PX à Los Alamos en 1944 (© LANL)

Auxiliaires féminines de l’armée (WACs) se détendant au PX des Special Engineer Detachment (SED)

La présence des femmes et des enfants dans ce lieu isolé rendit la vie beaucoup plus supportable pour tout le monde et améliora la cohésion du groupe. Cette présence induisit un très fort taux de natalité (330 naissances en deux ans), et l’hôpital construit sur le site dut prévoir un important service de gynécologie, une maternité et un service de pédiatrie. La présence de nombreux enfants nécessita également la construction d’une école primaire, d’un collège et d’une école technique de très haut niveau. À l’été 1943, il avait été envisagé que les cours soient assuré par les physiciens et leurs épouses, pour éviter de faire venir des enseignants extérieurs. De nombreux étudiants avaient suivi leurs professeurs, ou avaient été affectés par l’armée en tant que SED (Special Engineer Detachment). Une cafeteria de 250 places ouvrit en 1945. Un conseil municipal réglait de nombreux détails de la vie quotidienne, tels que les programmes du cinéma, l’ouverture des laveries, les problèmes de circulation (les rues n’avaient pas de trottoirs), le choix des produits disponibles aux PX (« Post eXchange ») ou au « commissary » malgré les restrictions du temps de guerre (il existait des tickets de rationnement pour de nombreux produits). Le conseil gérait aussi les relations entre les civils et les militaires : Los Alamos était officiellement une base militaire, entourée de barbelés et de postes de garde, même si les militaires y étaient très minoritaires.

Le dimanche était un jour de repos imposé à tous, et des bals très courus avaient régulièrement lieu le samedi soir (l’alcool n’était pas toujours facile à obtenir). L’épouse de Robert Bacher, Jean, disait que « On Saturday nights, the mesa rocked ». Les PX offraient un grill, un bar et un dancing avec juke-box. Une chaîne de radio locale, KRS, diffusait à l’intérieur du site des informations et de la musique. Otto Frisch y donna régulièrement des concerts de piano.

Otto Frisch au piano lors d’un des concerts qu’il donna régulièrement pour les auditeurs de Los Alamos.

Bal du samedi soir dans la salle commune de l’une des résidences pour célibataires (accueillant aussi des couples à l’occasion)

Beaucoup de physiciens pratiquaient avec ardeur la randonnée ou l’alpinisme en été, le ski ou le patinage en hiver. De l’équitation était aussi possible, l’armée avait acquis les chevaux du pensionnaire en même temps que le terrain et les bâtiments, et certains passionnés en avaient eux-mêmes acheté.

Patinage à Omega Canyon (Betty Williamson et John Michnowicz, un photographe qui prit de très nombreux clichés de la vie quotidienne à Los Alamos).

Robert Robinson et son père Charles goûtent aux joies de l’équitation dans la montagne. D’autres se contentaient des joies plus tranquilles de la pêche. Un golf rudimentaire de 9 trous fut installé.

Pueblo Canyon à proximité de Los Alamos

Excursion le dimanche à la montagne. Debout : Enrico Fermi, Hans Bethe, Hans Staub, Victor Weisskopf, un inconnu. Assis : Erika Staub, Elfriede Segrè, Bruno Rossi ? Emilio Segrè a probablement pris la photo. © AIP

Organisation du laboratoire

Comme le dit clairement le Los Alamos Primer : The object of the project is to produce a practical military weapon in the form of a bomb in which the energy is released by a fast neutron chain reaction in one or more of the material known to show nuclear fission.

Le rôle de Los Alamos était de réaliser une bombe, soit à partir de l’uranium 235 fourni par Oak Ridge, soit à partir du plutonium 239 fourni par Hanford. Groves avait fixé comme objectif qu’une bombe soit prête le 1° août 1945. Ce délai très court de deux ans interdisait la distinction habituelle entre recherche, conception et réalisation d’un prototype, et production industrielle en série après correction des imperfections initiales. Il fallait mener de front les recherches, en les focalisant sur la conception d’un design fiable, et la mise en place de la production. Cela impliquait un chevauchement des responsabilités entre les différents groupes. Il fallait également poursuivre toutes les voies en parallèle, sans craindre la redondance, pour éviter de se heurter un jour à un obstacle infranchissable en ne suivant que la voie jugée la plus prometteuse. Par exemple, bien que l’assemblage d’une masse critique par un « canon » parut plus sûre que la méthode d’implosion, celle-ci continua à être menée en parallèle (mais avec des effectifs réduits par manque de moyens humains).

Los Alamos fut un des premiers exemple de laboratoire fonctionnant « sur mission » : il devait réaliser une bombe opérationnelle : tout ce qui irait dans cette direction recevrait un financement illimité et les moyens humains nécessaires, tout le reste serait laissé de côté. Donc pas de recherche pure, pas de solution technique fondée sur une connaissance approfondie des lois physiques, un emploi extensif des approximations, une recherche de la fiabilité plus que de la performance, de larges emprunts à la méthodologie des ingénieurs, une hiérarchie quasi militaire (divisions, groupes, sous-groupes avec des responsables clairement identifiés rendant compte à leur supérieur direct) et des jalons imposés avec des revues d’étapes. Los Alamos a pu cependant conserver une certaine autonomie vis-à-vis de la direction du Programme Manhattan (Bush, Conant, Groves et leurs adjoints), gardant la maîtrise de la conception des bombes et du choix des méthodes et des matériaux (nucléaires en particulier).

Plan des installations scientifiques de Los Alamos au temps du programme Manhattan.

Du 15 avril au 6 mai 1943, une série de réunions rassembla la cinquantaine de scientifiques déjà arrivés pour organiser le laboratoire et en planifier les activités. Elles se tinrent dans les salles de classe du collège qui occupait les lieux avant de se faire déloger par l’armée, et se poursuivaient souvent au cours de randonnées dans la montagne environnante, ou dans le dortoir de l’école occupé en attendant la réalisation des appartements spartiates prévus pour les seniors (très relativement, la moyenne d’âge était de 32 ans) et des dortoirs pour les juniors. Oppenheimer avait 39 ans. La plupart des présents se connaissaient très bien, ayant déjà collaboré à de nombreuses reprises : Fermi, Condon, Rabi, Bethe, Bacher, Manley, Segrè, Wilson… Les discussions portèrent surtout sur le choix des recherches à effectuer et des priorités à décider parmi les problèmes techniques à résoudre. Il ne fut pas tellement question de l’organisation administrative, sinon un refus généralisé des scientifiques d’être placés sous autorité militaire et de se voire attribuer des équivalences de grades. Dans l’esprit de la plupart des participants, il devait s’agir d’un séjour bref, de quelques mois au grand maximum ! Au terme de ces réunions, beaucoup des participants repartirent dans leurs laboratoires d’origine pour rassembler le matériel et les personnes dont ils auraient besoin à Los Alamos. D’autres reprirent leurs activités antérieures, ne revenant à Los Alamos qu’épisodiquement comme Rabi. Fermi retourna à Chicago, passa du temps à Hanford puis à Oak Ridge, et il ne s’installa à Los Alamos qu’en août 1944.

Un laboratoire scientifique de Los Alamos en 1944

Oppenheimer organisa initialement le site de Los Alamos en quatre divisions, subdivisées en groupes : une division de physique théorique (division T), une de physique expérimentale (division P), une de chimie et métallurgie (division CM) et une d’artillerie (division E). Chaque division était répartie en plusieurs groupes de travail, ayant chacun une tâche précise, et un comité de coordination (rassemblant les responsables de division et les responsables administratifs) assurait la cohérence de l’ensemble. S’ajoutaient bien sûr les services administratifs, l’intendance, la sécurité militaire, les services de santé, etc. L’organisation fut modifiée à plusieurs reprises en fonction des nécessités, en particulier en juillet 1944 lorsqu’il fallut revoir tous les plans de réalisation des bombes. Au fur et à mesure de la montée en puissance de Los Alamos, Oppenheimer nomma des directeurs-adjoints pour l’épauler. Pour augmenter l’efficacité, Oppenheimer voulut que l’information circule aussi librement que possible entre les différents groupes ou divisions, malgré les fortes réticences des militaires chargés de la sécurité. Il finit par convaincre Groves que les ingénieurs et les physiciens travailleraient beaucoup plus vite de cette manière, et que la sécurité serait mieux assurée si tout le monde était conscient de l’importance des recherches et de la nécessité du secret vis-à-vis de l’extérieur. « When the American people know the reasons for secrecy, they can be depended upon to keep silent. » dit Ernest Lawrence en 1943. Oppenheimer institua dès mai 1943 un colloque (hebdomadaire, sous la pression de Bethe) rassemblant tous les seniors, et il chargea Teller de les organiser.

Divisions

La division T (physique théorique) fut placée sous la direction de Hans Bethe, avec cinq groupes :

- T-1 (hydrodynamique) dirigé par Edward Teller, puis Rudolf Peierls à partir de juin 1944

- T-2 (théorie de la diffusion) dirigé par Robert Serber

- T-3 (expériences et calculs d’efficacité) dirigé par Victor Weisskopf,

- T-4 (problèmes de diffusion) dirigé par Richard Feynman

- T-5 (calcul scientifique) dirigé par Donald A. Flanders

Son objectif était de calculer la meilleure configuration pour une bombe en tenant compte des données expérimentales au fur et à mesure qu’elles parvenaient. La priorité était donnée à l’assemblage par un canon, suivi par l’assemblage par implosion, la bombe à fusion défendue par Teller n’arrivant qu’en troisième rang malgré son intérêt évident à plus long terme. Les problèmes abordés touchaient évidemment à la physique nucléaire, mais aussi à l’hydrodynamique, à l’optique, à la chimie et la métallurgie et jusqu’à la géophysique.

Victor Weisskopf à l’époque de Los Alamos

Victor Weisskopf (1908-2002), théoricien autrichien, reçut son doctorat en 1931 à Göttingen, puis il travailla avec Heisenberg, Schrödinger, Bohr (Copenhague 1932-1933) et Pauli (Zürich 1933-1936). Il émigra aux États-Unis en 1937, s’installant à Rochester. Il fut un des pionniers de la renormalisation en électrodynamique quantique. Il rejoignit en 1943 le programme Manhattan à Los Alamos. Il fut en 1944 un des créateurs de la Federation of concerned scientists, puis milita beaucoup après la guerre contre les armes nucléaires (« Je n’hésite pas à dire que la seconde bombe est un crime » déclara-t-il, jugeant la guerre froide comme « un cas de maladie mentale collective. »). Il fut nommé professeur au MIT en 1945, mais ne rejoignit son poste qu’après la fin de la guerre. Au MIT, il dirigea le groupe de théorie du Laboratoire de Science Nucléaire, il y rédigea en 1952 Theoretical Nuclear Physics plus connu comme le « Blatt et Weisskopf ». Il dirigea le CERN de 1961 à 1966 avant de retourner au MIT diriger le département de physique de 1967 à 1973.

Maria Goeppert-Mayer

Maria Goeppert-Mayer

La division P (physique expérimentale) fut placée sous la direction de Robert Bacher, qui avait annoncé qu’il partirait dès que le site serait militarisé (ce qui n’arriva pas). Elle était divisée en cinq puis sept groupes :

- P-1 (cyclotron de Harvard) dirigé par Robert R. Wilson (Wilson avait 29 ans, il avait passé sa thèse en 1940 avec Lawrence, puis construisit avec DeWolf Smyth un séparateur isotopique électromagnétique, l’Isotron, rival du Calutron qui fonctionna en janvier 1942 à Princeton).

- P-2 (accélérateurs électrostatiques, deux Van de Graaff venus de l’université du Wisconsin, et un Cockroft- Walton) dirigé par John H. Williams, de l’université du Minnesota. Les accélérateurs furent mis en place au plus vite mais il fallut plusieurs mois avant qu’ils fonctionnent. Le cyclotron et surtout les van de Graaff fournirent l’essentiel des données sur les sections efficaces.

- P-3 (sources D-D) sous la direction de John Manley

- P-4 (électronique) sous la direction de Darol Forman (qui avait travaillé pour la Marine dans un laboratoire de San Diego, et pour le Met Lab de Chicago). Il fournissait l’appareillage indispensable aux autres groupes.

- P-5 (radioactivité) sous la direction d’Emilio Segrè (qui quitta en mai 1943 le laboratoire de Lawrence à Berkeley). Segrè installa un laboratoire de mesure de la radioactivité spontanée des isotopes de l’uranium et du plutonium dans une pittoresque cabane de rondins située dans une vallée isolée, à une trentaine de kilomètres de Los Alamos.

- P-6 (détecteurs) créé en septembre 1943 sous la direction de Bruno Rossi en fusionnant les équipes de Hans Staub et Bruno Rossi

- P-7 (le « water boiler » ou LoPo) créé en août 1943 sous la direction de Donald Kerst

Le liquéfacteur à hydrogène fut opérationnel en avril 1944, et Earl A. Long obtint au cours de l’hiver suivant du deutérium liquide.

Robert Bacher

Robert Bacher

Robert Fox Bacher (1905-2004) passa son doctorat à l’université du Michigan, fut post-doc d’Oppenheimer à Caltech avant de devenir professeur de physique à Cornell en 1935, où il collabora avec Bethe (corédacteur de la « bible » de Bethe). Il devint en 1946 directeur du Laboratoire d’études nucléaires de Cornell, avant de rejoindre Caltech en 1949, où il dirigea la division de physique avant de devenir vice-président de l’institut en 1962. Dans les années 1950, il fut membre de l’AEC et un des grands soutiens d’Oppenheimer.

La division CM (chimie et métallurgie) fut dirigée par Joseph W. Kennedy, qui n’avait alors que 27 ans. Ses objectifs étaient la purification du plutonium produit par les réacteurs (dont on s’attendait à ce qu’il soit beaucoup plus contaminé par des produits de fission que celui produit par les cyclotrons), la métallurgie du plutonium et de l’uranium, et la fourniture de sources radioactives comme le polonium et le radio-lanthane. Pendant la construction d’une grande « salle blanche » sans poussières, Kennedy coordonna les recherches sur la métallurgie du plutonium menées au Met Lab de Chicago, mais aussi au département de chimie de Berkeley et dans l’Iowa. Charles A. Thomas, de Monsanto, vint en juillet 1943 diriger la chimie du plutonium.

Joseph W. Kennedy

Joseph W. Kennedy

Joseph William Kennedy (1916-1957) fut en 1941 l’un des découvreurs du plutonium (avec Seaborg, McMillan et Wahl). Il passa son doctorat de chimie en 1939 à Berkeley. À Los Alamos, son rôle de gestionnaire fut essentiel. En 1946 il devint professeur de chimie à la Washington University de Saint Louis.

La division E (Ordnance Engineering, artillerie) fut placée sous la responsabilité du capitaine de vaisseau (captain) William S. (« Deke ») Parsons de l’US Navy, qui prit ses fonctions en juin 1943. Les différents groupes étaient cependant presque tous dirigés par des physiciens.

Wiliam « Deke » Parsons en 1945

Wiliam « Deke » Parsons en 1945

Le capitaine de vaisseau (plus tard contre-amiral) William Sterling Parsons (1901-1953) était un spécialiste de l’artillerie et des explosifs. Il travailla au Naval Research Laboratory sur le radar et les fusées de proximité de 1939 à 1943. Il devint le 15 juin 1943 le directeur de la division E, en charge de la réalisation matérielle des bombes. Après avoir assisté à l’essai Trinity, il se rendit à Tinian diriger l’assemblage des bombes, et il participa à la mission sur Hiroshima, au cours de laquelle il arma la bombe. Après la guerre, il fut responsable des opérations nucléaires, dirigeant en juillet 1946 l’Operation Crossroads (les essais nucléaires à Bikini). L’amiral Parsons fut ensuite membre de l’AEC tout en occupant de hautes fonctions à l’US Navy jusqu’à sa mort soudaine en 1953.

La division E fut initialement divisée en 6 groupes, atteignant finalement 11 groupes en juin 1944, juste avant le grand remodelage de l’été 1944.

- E-1 (polygone d’essai) Edwin McMillan du Rad Lab du MIT (après celui de Berkeley)

- E-2 (instrumentation) Kenneth T. Bainbridge du laboratoire du cyclotron à Harvard, remplacé par Lyman Parrat début 1944 quand Bainbridge prit la direction du groupe E-9

- E-3 (détonateurs) Robert B. Brode du département de physique de Berkeley

- E-4 (projectile, cible et source) Charles H. Crichtfield du National Bureau of Standards

- E-5 (essais d’implosion) Seth Neddermeyer du National Bureau of Standards (remplacé par George Kistiakowsky en février 1944)

- E-6 (ingénierie)

- E-7 (transport de la bombe) créé à l’automne 1943 sous la direction de Norman Ramsay (projet Alberta)

- E-8 (ballistique intérieure) créé à l’automne 1943 sous la direction de Joseph Hirschfelder

- E-9 (assemblages explosifs) créé début 1944 sous la direction de Kenneth Bainbridge

- E-10 (site d’essai) créé en juin 1944 sous le commandement du Major W.A. Stevens

- E-11 (détonateurs électriques et tests RaLa = lanthane 140 radioactif servant à tester l’implosion) créé en juin 1944 sous la direction de Luis Alvarez

Les constructions des logements, des ateliers et des laboratoires avancèrent rapidement. Un cyclotron et plusieurs accélérateurs linéaires furent apportés de Harvard, de Chicago ou de l’université du Wisconsin. Une installation de liquéfaction de l’hydrogène figura parmi les premiers équipements : elle était destinée aux travaux sur la Super, la bombe à fusion de Teller.

PREMIERS TRAVAUX

Le 24 juin 1943, Segrè mesura le taux de fission spontanée du plutonium (produit par un cyclotron) à 5 fissions/kg/s. Ce taux permettait tout à fait d’envisager l’assemblage d’une masse critique de plutonium par un canon, comme cela avait été envisagé lors du Summer Study de Berkeley, et donna le feu vert aux travaux sur la bombe Thin Man. Du 10 au 15 juillet, la mesure du nombre de neutrons secondaires indiqua que chaque fission produisait en moyenne 3 neutrons. En mars 1944, Segrè revit à la hausse, à 11 fissions/kg/s, le taux de fissions spontané du plutonium (essentiellement du plutonium 239) toujours produit par les cyclotrons. Cela réduisait nettement les marges de sécurité pour Thin Man, mais cela demeurait acceptable. Ce n’est qu’en décembre 1943 que le plutonium produit par le réacteur pilote X-10 à Oak Ridge commença à être isolé. Segrè n’en disposa pas avant mars 1944.

Le Planning Board évoqua le 30 mars 1943 [avant les conférences de Serber ? cf. Critical assembly p.86] la possibilité de comprimer une sphère creuse au-delà de la masse critique, et décida le 2 avril de demander à la division T une étude de la question. Neddermeyer débuta le 4 juillet ses expériences d’implosion avec des tubes cylindriques, mais il ne parvint pas à obtenir une implosion symétrique. Son équipe était réduite à trois assistants, car Parsons ne jugeait pas ces travaux prioritaires. Lors d’une visite le 20 septembre, von Neumann souligna fortement l’intérêt de l’implosion pour atteindre des densités de cœur plus élevées, avec le double gain de réduire la masse critique nécessaire et d’augmenter le rendement de la fission. Bethe et Teller commencèrent à étudier la question d’un point de vue théorique, avec l’appui d’Oppenheimer et de Groves, et von Neumann promit d’étudier la physique de l’implosion à ses moments perdus. Pour épauler cet effort, Oppenheimer suggéra le 23 septembre de recruter George Kistiakowsky qui supervisait à l’OSRD les travaux sur les explosifs. Kistiakowsky arriva en janvier 1944 à Los Alamos.

Entretemps, le 17 septembre 1943, un premier essai de canon à grande vitesse pour Thin Man fut réalisé. En décembre, Segrè mesura le taux de fission spontanée de l’uranium 235 et le trouva inférieur aux attentes. Cela permit d’envisager une vitesse d’assemblage plus faible, et donc un canon plus court et plus léger (ce fut Little Boy).

En novembre 1943, après les accords de Québec, arrivèrent à Los Alamos les premiers membres de la délégation britannique, dirigée par Chadwick. La plupart avaient été membres du Comité MAUD, ou étaient des experts en physique nucléaire ou en explosifs. Parmi eux, George Placzek, William Penney (qui dirigea après guerre le programme britannique d’armement thermonucléaire), Philip Moon, James Tuck, Egon Bretscher, Klaus Fuchs et bien sûr Otto Frisch et Rudolf Peierls.

William Penney, Otto Frisch, Rudolf Peierls et John Cockroft © Corbis

Bohr avait fui le Danemark pour la Suède en octobre 1943, puis rejoint la Grande-Bretagne en avion (manquant de périr d’asphyxie au cours du vol) avant d’arriver (en décembre ?) à Los Alamos comme consultant, participant à de nombreuses discussions mais sans avoir de tâche fixée.

Billet danois de 500 couronnes à l’effigie de Niels Bohr.

Niels Bohr (?) à Los Alamos

Fat Man, Thin Man et Little Boy

La difficulté majeure de la réalisation d’une bombe nucléaire, une fois qu’on dispose d’assez de matériau fissile, est de parvenir à en fissionner le maximum — en maintenant la cohésion de la bombe — avant que l’énergie dégagée de plus en plus rapidement n’en disperse les éléments, et stoppe de ce fait la réaction en chaîne. Dès 1940, Frisch et Peierls avaient indiqué qu’il fallait pour cela rassembler nettement plus d’une masse critique (de l’ordre de 2 ou mieux 3 pour que le rendement de l’explosion ne soit pas négligeable). Mais pour éviter une explosion prématurée, il fallait :

- conserver le matériau fissile dans un état sous-critique jusqu’au moment voulu ;

- le rassembler et l’amener dans un état critique suffisamment rapidement pour que les neutrons (toujours présents) n’aient pas le temps de déclencher la réaction en chaîne ;

- introduire des neutrons quand l’état critique est atteint.

La masse critique dépend de manière sensible de la forme du matériau fissile : un cylindre, et a fortiori un cylindre creux, ou une sphère creuse ont une masse critique nettement plus élevée qu’une sphère pleine. Le calcul de la masse critique d’uranium était un problème très difficile à résoudre à l’automne 1943 car les théoriciens ne parvenaient pas à trouver une façon de ramener les équations de diffusion des neutrons dans des géométries plus complexes qu’une sphère homogène (un cylindre plein et un cylindre creux par exemple) à des formes analytiquement intégrables. Un calcul d’ordre de grandeur n’est pas trop difficile, mais il fallait être précis pour être juste sous-critique, et pas super-critique ! Des méthodes semi-analytiques, voire complètement numériques, furent progressivement mises au point (méthode de Serber-Wilson en particulier, qui servit jusque dans les années 1950). Ce fut une des premières applications de calcul numérique à grande échelle effectué par le groupe T-5, et la lenteur des calculs incita à l’achat de machines IBM à cartes perforées, qui ne furent pas livrées avant le printemps de 1944 (où elles servirent d’ailleurs surtout aux calculs d’implosion).

Sphère pleine de 0.9 mcritique + Sphère creuse de 0.9 mc (~2mcx(2/3)2) = sphère pleine de ~2.7mc

La masse critique varie aussi avec la densité du matériau, étant inversement proportionnelle au carré de cette densité. D’où les deux idées avancées lors du Summer Study de Berkeley : assembler plusieurs masses sous-critiques sans modifier leur densité, ou augmenter la densité d’une masse sous-critique. Dans le premier cas, le plus simple était de tirer un projectile cylindrique creux sur une cible cylindrique pleine (qui remplirait le creux), dans le second cas l’idée était de comprimer une sphère creuse pour en faire une sphère pleine.

L’implosion présentait, sur le papier, de nombreux avantages.

- la matière étant dirigée vers le centre, ce mouvement s’oppose à l’expansion provoquée par la libération d’énergie de la réaction en chaîne, qui progresse alors plus longtemps avant que la bombe soit dispersée. Le rendement d’une bombe à implosion est donc bien supérieur à celui d’une bombe-canon (15 à 20% au lieu de 1 à 2%).

- la méthode d’implosion évitait le risque d’une explosion involontaire : la quantité totale de matériau fissile était nettement sous-critique (donc sans aucun risque d’explosion prématurée), et ne devenait super-critique qu’au terme de l’implosion et encore seulement si l’implosion était parfaitement réussie. Par contre, il se révéla extraordinairement difficile de synchroniser une implosion parfaitement régulière, il était bien plus simple (et plus sûr) de mettre à feu un obus de canon.

- l’implosion présentait un troisième avantage, qui se révéla crucial pour la bombe au plutonium. La présence inévitable de neutrons dus au rayonnement cosmique et surtout dus à la fission spontanée, rare mais pas inexistante, de l’uranium et du plutonium pouvait déclencher prématurément la réaction en chaîne au cours de l’assemblage. Il était donc indispensable de rassembler le matériau fissile dans l’état supercritique en un temps inférieur à celui qui sépare deux fissions spontanées. La méthode de compression était là aussi préférable car l’assemblage s’effectue en quelques microsecondes, alors que l’assemblage obus-cible d’une bombe-canon s’effectue plutôt en quelques millisecondes, laissant plus de temps aux neutrons parasites pour déclencher une réaction en chaîne prématurée.

En septembre 1943, la direction de Los Alamos décida d’intensifier les travaux sur l’implosion en faisant appel à Kistiakowsky (qui arriva en janvier 1944), Neddermeyer gardant en principe la responsabilité du groupe E-5. Mais les relations entre les deux hommes devinrent de plus en plus difficiles, Neddermeyer menant les recherches avec un sérieux académique mal adapté à une situation en évolution rapide, et le 16 février il fut remplacé par Kistiakowsky. Un groupe d’étude théorique de l’implosion, dirigé par Teller, fut parallèlement créé le 11 janvier dans la Division T. Teller fut remplacé en mai, en raison de conflits avec Bethe, et de son obsession pour « Super », la bombe à fusion.

Entretemps, sur les suggestions de von Neumann, l’idée de comprimer une sphère creuse fut remplacée par celle de comprimer une sphère pleine (le « cœur de Christy »). Il paraissait plus facile d’obtenir ainsi une compression régulière, mais surtout cela conduisait à augmenter la densité du plutonium ou de l’uranium. La densité finale plus élevée impliquait une masse critique plus petite, et elle exploitait mieux une quantité limitée de matière fissile. De plus, la densité plus élevée réduisait le libre parcours moyen des neutrons, donc l’intervalle entre deux fissions, et donc diminuait le risque de prédétonation.

Les deux configurations, canon et implosion, furent étudiées en parallèle sous les noms de Thin Man et Fat Man. Quand il apparut fin 1943 qu’une version raccourcie de Thin Man suffirait pour l’uranium, elle fut baptisée Little Boy (le petit garçon). Après la guerre, les bombes reçurent les noms plus officiels de Mark 1 pour Little Boy, Mark 2 pour une bombe à implosion qui ne dépassa pas le stade théorique et Mark 3 pour Fat Man. Les modèles de bombes reçurent des désignations allant jusqu’à Mark 27, les têtes nucléaires des missiles recevant elles des désignations en W (pour warhead, « tête militaire »).

Evolution des bombes nucléaires 1945-1986

CALCUL NUMÉRIQUE

Les problèmes à résoudre

Le groupe T-5 dirigé par le mathématicien Donald Flanders était le groupe le plus nombreux de la division de théorie, rassemblant environ 25 personnes en 1944. Son personnel était en majorité féminin (des épouses de scientifiques et des femmes du Women’s Army Corps), mais il comprenait aussi des scientifiques militaires (le Special Engineering Detachment) et quelques brillants théoriciens comme Stanislaw Ulam, Richard Feynman ou Nicholas Metropolis. Les épouses des physiciens (comme Mary Frankel, Josephine Elliott, Beatrice Langer, Mici Teller, Jean Bacher, Betty Inglis) utilisaient plutôt le papier et le crayon, les professionnelles du WAC des calculatrices de bureau, et les spécialistes du SED (le plus souvent de jeunes étudiants) les tabulatrices à cartes perforées.

Calculs longs et complexes pour

- diffusion (transport) des neutrons

- transferts de rayonnement

- implosion, détonation

- explosion, hydrodynamique boule de feu, onde de choc

Les problèmes d’hydrodynamique conduisent à des équations aux dérivées partielles hyperboliques non- linéaires. Les solutions peuvent présenter des discontinuités, et il peut être risqué de remplacer une équation différentielle par une équation aux différences finies, car les dérivées peuvent devenir infinies. Les machines à cartes perforées étaient utilisées pour les parties régulières des flux, aussi longtemps que possible, et le raccord aux discontinuités (le front de l’onde de choc) était effectué à la main. Les problèmes étaient souvent traités en 1 dimension, soit en supposant une symétrie sphérique, soit une symétrie cylindrique (avec un cylindre infini), rarement en 2 dimensions (et jamais en 3). Des hypothèses simplificatrices étaient nécessaires pour ramener le problème à une forme soluble, généralement en passant d’équations aux dérivées partielles à des équations différentielles, plus simples, et/ou en paramétrant la forme des surfaces. Mais de cette manière, on risquait de passer à côté des instabilités naissant à la jonction de deux surfaces (Rayleigh-Taylor en particulier).

Le calcul du transport des neutrons aboutissait à une équation intégro-différentielle linéaire : la variation du nombre de neutrons en un point, ayant une vitesse donnée, dépend de la diffusion dans toutes les directions de tous les neutrons passant par ce point. Quand le problème avait une symétrie spatiale (sphérique de préférence) et que la longueur de diffusion (libre parcours moyen) était petite, le problème était à peu près soluble. Mais il se compliquait rapidement si la géométrie n’était pas homogène, les centres diffuseurs en mouvement, la longueur de diffusion comparable à la taille du système, ou plus grande, et si le nombre de neutrons n’était pas très grand (limite discrète). Cette situation se trouve précisément réalisée pour une masse légèrement supercritique, si l’on veut calculer la probabilité qu’un neutron initie une réaction en chaîne avant d’être absorbé ou de s’échapper (ou de provoquer une fission mais que tous les neutrons secondaires s’échappent). C’est pour résoudre ce genre de situation que la méthode de Monte-Carlo fut inventée. Mais avant cela, Robert Serber et Robert Wilson mirent au point une méthode semi-analytique, avec des fonctions hyperboliques et des exponentielles intégrales (remplacée ensuite par celle de Bengt Carlson dans les années 1950).

Franken et Nelson développèrent des méthodes de discrétisation des équations aux dérivées partielles nécessaires au calcul numérique, en décomposant les calculs complexes en plusieurs calculs simples distribués aux calculateurs humains. Pour éviter les erreurs, les calculs à mener étaient décomposés en tâches élémentaires, et ils étaient systématiquement exécutés par deux (ou trois) personnes indépendamment, avec des vérifications intermédiaires pour éviter de propager des erreurs. De nombreux calculs pouvaient être parallélisés : pour la résolution numérique des équations différentielles en hydrodynamique, par exemple, il était relativement facile de donner à chaque personne un des « pas » de l’itération des équations en un point de l’espace, et de lui demander de transmettre son résultat à la personne suivante dans le réseau. Flanders mit au point des feuilles spéciales facilitant la mise en place et l’exécution de ces calculs.

Calculatrices à main

Pour l’exécution des calculs eux-mêmes, si la règle à calcul demeurait l’outil de base des physiciens et des ingénieurs, « l’ordinateur humain multiprocesseur » réalisé par les équipes de calculatrices (humaines et mécaniques) utilisait des machines de bureau. La règle à calcul avait cependant l’avantage d’obliger à réfléchir aux ordres de grandeur des résultats attendus, avant de se lancer dans des calculs longs et complexes. Il n’y eut pas d’analyseurs différentiels à Los Alamos, mais des calculatrices de bureau électromécaniques, et aussi un petit nombre de machines à cartes perforées (à vocation initialement comptable ou statistique, Bureau of Census). Le premier ordinateur électronique, ENIAC, ne fut utilisé que dans les derniers mois de la guerre, et encore à distance (Aberdeen Proving Grounds ou Moore School ?).

Calculatrices Marchant (à gauche) et Monroe (à droite)

Publicité des années 1940 pour une calculatrice Friden ST

Le parc initial de calculatrices comprenait des modèles Marchant, Monroe et Friden, les meilleurs disponibles à l’époque, mais Flanders le standardisa rapidement en choisissant des modèles Marchant (quelques irréductibles conservèrent leur Monroe). En raison de leur utilisation extrêmement intensive, les calculatrices mécaniques ou électromécaniques s’usèrent rapidement et elles s’enrayèrent de plus en plus souvent. Mais les renvoyer au fabricant pour réparation prenait trop de temps (Los Alamos était très isolé), aussi Metropolis et Feynman se mirent-ils à les désosser, à comprendre leur fonctionnement interne, et à déterminer quelles pièces étaient le plus souvent responsables des pannes. Ils devinrent ainsi rapidement des virtuoses du dépannage. Quand Bethe, directeur de la division de théorie, apprit cela, il estima que ces activités n’avaient pas de rapport avec les tâches pour lesquelles ils avaient été affectés à Los Alamos. Il commença par les exclure de l’atelier de réparation, mais il leva très vite l’interdiction quand le nombre de machines de bureau disponibles diminua de manière critique.

Richard Feynman

Richard Feynman

Tabulatrices IBM à cartes perforées

À l’automne 1943, il devint rapidement apparent que les besoins en calcul numérique dépassait les capacités des calculatrices mécaniques : il fallait compter six à huit mois pour effectuer le calcul nécessaire pour chacune des formes non-sphériques. Bethe mentionna ce problème lors d’une réunion des responsables de Los Alamos. Le responsable de la logistique à Los Alamos, Dana Mitchell, avait travaillé à Columbia avec l’astronome Wallace John Eckert, qui utilisait depuis une dizaine d’années des tabulatrices IBM à cartes perforées pour effectuer de longs calculs astronomiques portant sur le mouvement des planètes et l’établissement d’éphémérides. Ne pas confondre W.J. Eckert avec J. Prespert Eckert, co- inventeur avec John Mauchly de l’ENIAC, le premier calculateur électronique programmable.

Répondant à la demande de Bethe, Mitchell estima que la durée d’un calcul serait réduite de six mois à quatre semaines avec des tabulatrices IBM 601, et il en commanda 3 en décembre. Elles arrivèrent en avril 1944, et furent immédiatement mises à contribution (mais pour les calculs relatifs à l’implosion). Metropolis et Feynman doutèrent de leur utilité, et ils organisèrent un concours entre machines à cartes perforées et dames armées de calculatrices Marchant. Devant exécuter les mêmes calculs, les deux équipes restèrent au coude à coude pendant la première journée, mais la fatigue se fit sentir et les calculatrices humaines prirent un retard croissant. Cette compétition avait surtout pour but de vérifier que la procédure employée avec les tabulatrices donnait bien les mêmes résultats que la procédure éprouvée avec les calculatrices à main. Le groupe T-5 fut alors réorganisé : pour tirer le meilleur parti des nouvelles machines, un groupe T-6 fut créé sous la direction de Frankel et le rythme de travail ne cessa de s’accélérer.

IBM 601, capable de réaliser une multiplication par seconde

L'intérieur d'une IBM 601

En raison du secret, IBM ne savait pas à quoi allaient servir les machines, et ne put envoyer une équipe pour les monter et les mettre en service. Feynman, Frankel et Nelson durent terminer eux-mêmes le montage à partir des schémas de câblage. La mathématicienne Naomi Livesey arriva de l’université de l’Illinois à Urbana-Champaign en février 1944 pour superviser l’équipe de civils et de militaires en charge des machines. Elle avait acquis une bonne expérience des tabulatrices IBM en effectuant des études statistiques et des sondages pour estimer les coûts de diverses administrations pour le compte de Princeton Surveys (relevant de la School of Public and International Affairs de l’université de Princeton). Elle fut assistée à partir de l’été par Eleanor Ewing qui enseignait les mathématiques chez Pratt & Whitney.

Une IBM 405 capable de lire des cartes perforées, d’effectuer des calculs sur les données, et d’imprimer les résultats

Le groupe disposa au printemps 1944 de trois IBM 601, capables de lire sur une carte perforée deux nombres de 8 chiffres, de les multiplier et de perforer le résultat sur la même carte, le tout en une seconde. L’IBM 601 pouvait également effectuer des additions et des soustractions, calculer un inverse (et donc effectuer une division). L’IBM 601 fut l’outil de base du groupe T-6, mais le groupe disposa également de machines limitées aux additions et soustractions (IBM 405), de perforatrices (IBM 031), de duplicatrices de cartes (IBM 513) et de trieuses (IBM 075). Avec cet arsenal, les calculs qui prenaient six mois purent être effectués en trois semaines, et l’optimisation des méthodes de calcul permit de ramener ce temps à trois jours à la fin de la guerre. Feynman remarqua que certains calculs commençaient sur une machine, par une multiplication par exemple, puis continuait sur une deuxième, par une addition, puis sur une troisième… avant de revenir à la première pour une nouvelle multiplication. Il eut l’idée d’utiliser des cartes de couleurs différentes (pour éviter de les mélanger) qui parcouraient le même cycle mais avec un décalage de un, deux et trois rangs, ce qui multipliait par quatre la vitesse de calcul (dans cet exemple). Cependant, l’ensemble des calculs nécessaires à la mise au point de l’implosion dura quand même plusieurs mois, et ils n’auraient jamais pu être menés à bien sans ces machines.

La petite perforatrice IBM 031 © IBM

Les nombres étaient représentés par un signe, un chiffre, sept décimales et un exposant (en fait 50 + le vrai exposant), et on entrait le premier opérande, l’opération puis le second opérande, la machine donnant le résultat. Des fonctions plus complexes (racine, puissance, sinus, exponentielle, logarithme) pouvaient être câblées à la manière d’un standard téléphonique. L’opérateur, assis devant la machine, installait les paquets de cartes, recalait si nécessaire, surveillait les listings et intervenait en cas de panne. L’Armée avait fourni un réparateur agréé IBM, un GI mobilisé, mais pannes intermittentes et, pire, erreurs de calcul, étaient très fréquentes (de l’ordre de une tous les trois pas d’intégration). Les relais étaient en effet sensibles à la poussière et aux vibrations des camions qui ne cessaient de passer sur la route mal pavée devant le bâtiment. Il s’avéra plus indispensable que jamais de dupliquer systématiquement tous les calculs.

Duplicatrice IBM 513 analogue à celle de la division de théorie à Los Alamos

Pour aller plus vite, la division T commanda en mai 1944 à IBM des machines « sur mesure » capable d’effectuer des multiplications multiples, ainsi que des divisions. Nelson rencontra même en juin à New York le vice-président d’IBM, John McPherson, pour préciser ses demandes et les nouvelles machines arrivèrent à Los Alamos à la fin de 1944.

Trieuse de cartes IBM 075

Frankel contracta ce que Feynman appela « la maladie des ordinateurs », se passionnant pour leur fonctionnement et les manières de l’améliorer, en perdant de vue leur finalité pratique. Après la guerre, il se consacra d’ailleurs entièrement aux ordinateurs. Ses relations étaient difficiles avec les personnels sous ses ordres, en particuliers les appelés du SED. Bethe confia alors la direction du groupe T-6 à Feynman, qui expliqua aux jeunes militaires les objectifs de leur travail, développer une arme pour terminer la guerre plus vite, ce qui les passionna et les amena à mettre aux point des méthodes de calcul de plus en plus efficaces.

Calculs numériques

La simulation de l’onde de choc de l’implosion nécessitait la résolution d’une équation hyperbolique aux dérivées partielles. La symétrie sphérique permettait de se ramener à une dimension d’espace seulement (et une dimension de temps), sauf bien sûr à l’interface entre les deux types d’explosifs (« lent » et « rapide »). Les machines n’étaient programmées que pour calculer l’évolution de l’onde de choc dans le matériau homogène, et le calcul de la transition à l’interface était effectué à la main, en général en parallèle par Naomi Livesey et par Tony Skyrme (de la mission britannique). Cela leur prenait 6 à 8 heures, puis ils comparaient leurs résultats avant de les introduire à nouveau dans la machine pour la suite des calculs. L’expérience aidant, ce calcul d’interface fut abandonné quand il apparut que les solutions numériques des équations se stabilisaient rapidement après leur traversée.

Ulam, Feynman et von Neumann

La procédure numérique consistait à évaluer l’équation différentielle en un certain nombre de points de l’espace (en une dimension seulement) ce qui donnait une pile de cartes perforées représentant l’état de l’implosion à un instant donné. Le passage de cette pile à travers la série de machines, chacune effectuant une opération élémentaire (addition, soustraction, multiplication ou division), correspondant à un pas d’intégration temporelle, et il engendrait une nouvelle pile de cartes. Il ne restait qu’à répéter l’opération pour suivre le développement de l’implosion puis de l’explosion. Chaque configuration du cœur, de l’enveloppe (tamper) et des explosifs nécessitait un calcul séparé.

Le premier calcul d’implosion sur les IBM dura 3 mois, de février avril 1944, et il concerna la simulation d’un cœur creux, l’idée initiale précédant celle de Christy d’un cœur plein. 7 autres calculs se déroulèrent jusqu’à la fin de 1944, concernant surtout le cœur plein de Christy, et 17 autres en 1945 (cœur plein puis « levitated pit » en mars et premiers essais de miniaturisation). Ces calculs furent validés par l’essai Trinity. Les machines fonctionnaient 24h/24 (mais 6 jours sur 7 seulement) grâce à 3 équipes du SED qui se relayaient.

Pour gagner du temps, la division T-6 procéda à des simulations exploratoires d’un grand nombre de configurations puis, en fonction des résultats, elle se focalisa sur une configuration particulière sur laquelle fut menée une simulation beaucoup plus détaillée. Cette configuration, Mark III, fut celle de Fat Man (Mark I était Little Boy et Mark II une autre configuration d’implosion, inférieure à Mark III et jamais réalisée). Les calculs théoriques furent largement menés indépendamment des expériences, par manque de temps.

Programmation d’une opération complexe sur une IBM 601 à Los Alamos

Von Neumann se passionna pour l’utilisation des cartes perforées et il s’initia à leur emploi avec Livesey et Ewing, dont il partageait le bureau lors de ses passages à Los Alamos. Metropolis raconte qu’il était très irrité par le câblage des IBM : il rendait possible la réalisation d’opérations en parallèle, mais il fallait être très attentif à la durée relative de ces opérations, et von Neumann en conclut qu’il était préférable de ne pas avoir recours aux opérations en parallèle dans les ordinateurs électroniques qu’il conçut par la suite (architecture « de von Neumann »). Par la suite, von Neumann se passionna pour les calculateurs électromécaniques à relais, le Relay Computer de George Stiblitz aux Bell Labs, et surtout le Mark I de Howard Aiken à Harvard (initialement construit d’ailleurs de 1939 à 1943 chez IBM sous le nom d’Automatic Sequence-Controlled Computer). Un des calculs exécutés à Los Alamos fut testé au printemps 1944 sur le Mark I : le calcul dura en fait plus longtemps, mais avec une précision numérique très supérieure. Le Mark I mettait 1/3 s pour faire une addition, 6 s pour une multiplication et une minute pour un log ou un sinus. C’était une machine imposante : 15 mètres de long, 5 tonnes, 750 000 composants, 2200 roues de registres, 3300 relais, 800 kilomètres de câblage.

Le Harvard Mark I (ou IBM ASCC) de Howard Aiken, à Harvard aujourd’hui

Neumann János (John von Neumann) à l’époque de Los Alamos© LANL

Neumann János ou John von Neumann (1903-1957) né à Budapest, PhD en maths en 1926 à Budapest, part à Berlin puis aux USA où il devient (avec Einstein et Gödel) un des membres fondateurs de l’IAS de Princeton en 1933. Travaux en logique mathématique, théorie axiomatique des ensembles, fondations mathématiques de la mécanique quantique en 1932, économie et théorie des jeux en 1944, informatique en 1944 (l’architecture de tous les ordinateurs suit les règles établies par von Neumann) et stratégie nucléaire militaire (théorie de la « destruction mutuelle assurée ») dans les années d’après guerre.

Von Neumann jouait le rôle d’expert en ondes de choc auprès de l’OSRD et auprès de l’Armée (tant au Bureau of Ordnance qu’au Balistique Research Laboratory à Aberdeen dans le Maryland). C’est d’ailleurs par ce canal qu’il apprit d’Herman Goldstine l’existence du projet ENIAC de calculateur électronique pour la mise au point de tables de tir (à l’époque, une centaine de femmes, armées de calculatrices électromécaniques, calculaient les trajectoires des obus, à raison de 750 calculs par trajectoire, ce qui leur prenait deux semaines ; une table standard – pour un canon et un obus donnés – contenait 3000 trajectoires et il fallait quatre ans à l’équipe pour l’achever). Cela ressemblait beaucoup aux problèmes de calcul rencontrés à Los Alamos, et il n’est pas surprenant que von Neumann ait immédiatement voulu utiliser l’ENIAC, mais il ne fut achevé que fin 1945. Il n’était pas programmable, la séquence de calculs étant déterminée par le choix des branchements et la position des interrupteurs pour chacune des milliers d’étapes. Les données étaient fournies et stockées sur des (millions de) cartes perforées. Von Neumann contribua à ses successeurs, l’EDVAC, qui était programmable, puis l’IAS Machine et ses dérivés (ILIAC, MANIAC).

Évolution de la puissance (mesurée en nombre d'instructions exécutées par seconde) des ordinateurs depuis 1940 montrant l'accrossement exponentiel (loi de Moore): un ordinateur portable actuel (Intel Core i7) est cent milliards de fois plus puissant que l'ensemble de la division T de Los Alamos au temps du programme Manhattan.

Fusion ?

Le groupe de Teller, dans la division T puis dans la division F après la réorganisation de l’été 1944, avait peu à peu réalisé que la complexité des calculs était beaucoup plus grande pour la fusion que pour la fission. Il ne suffisait pas de suivre la diffusion de neutrons dans un matériau neutre et quasi-statique, mais de particules chargées (les noyaux) dans un plasma, la notion de masse critique était remplacée par celle de température d’allumage (et la température variait dans tout le volume), et il fallait s’assurer que la combustion était auto-entretenue et ne s’éteignait pas. L’estimation des opacités nucléaires était un problème crucial, et en avril 1945 Teller demanda pour cela l’aide de Maria Goeppert-Mayer à Columbia et celle d’Eckert (à Columbia aussi) pour les calculs (les IBM de Los Alamos étant réservées aux calculs d’implosion). Les Frankel et Metropolis passèrent l’été 1945 à préparer les calculs d’allumage du deutérium (en 1 dimension supposant une symétrie sphérique), puis ils modifièrent le codage pour l’ENIAC : ce fut le premier calcul mené sur cette machine et il dura 6 semaines (décembre 1945-janvier 1946).

En raison des nombreuses simplifications nécessaires (Compton inverse négligé, bremsstrahlung simplifié, réchauffement du deutérium par celui qui fusionnait négligé), le résultat n’était concluant ni dans un sens ni dans l’autre : l’allumage du deutérium par une bombe à fission semblait malgré tout très improbable. Une conférence se déroula en avril 1946 (rapport secret LA-575) pour faire le point, les conclusions optimistes de Teller étant critiquées, par Serber en particulier.

The design at that time was for a gun-type uranium fission bomb to be surrounded by about a cubic meter of liquid deuterium, with the whole assembly being encased in a heavy tamper. A large but undetermined amount of tritium would be required to ignite the reaction.

La crise de l'été 1944 et la réorganisation du laboratoire

Plutonium 240 Early experiments on both uranium and plutonium provided welcome results. Uranium emitted neutrons in less than a billionth of a second- just enough time, in the world of nuclear physics, for an efficient explosion. Emilio Segrè later provided an additional cushion with his discovery in December 1943 that, if cosmic rays were eliminated, the subcritical uranium masses would not have to be brought together as quickly as previously thought; nor would the uranium have to be as pure. Muzzle velocity for the scaled down artillery piece could be lower, and the gun could be shorter and lighter. Bacher's engineering division patiently generated the essential cross-sectional measurements needed to calculate critical and efficient mass. (The cross section is a measurement that indicates the probability of a nuclear reaction taking place). The same group utilized particle accelerators (Van de Graaf) to produce the large numbers of neutrons needed for its cross-sectional experiments. Bacher's group also compiled data that helped identify tamper materials that would most effectively push neutrons back to the core and enhance the efficiency of the explosion. Despite Los Alamos's postwar reputation as a mysterious retreat where brilliant scientists performed miracles of nuclear physics, much of the work that led to the atomic bombs was extremely tedious.

Le 5 avril 1944, arrivèrent les premiers échantillons de quelques grammes de plutonium venant du réacteur expérimental X-10 d’Oak Ridge. Emilio Segrè les utilisa pour mesurer plus précisément les sections efficaces du plutonium et affiner l’évaluation de la masse critique de plutonium nécessaire (selon la configuration choisie). À la différence du plutonium synthétisé avec les cyclotrons, le plutonium 239 des réacteurs était contaminé par 0.1% de plutonium 240. C’était prévisible, puisque restant dans le réacteur une fois formé, le plutonium 239 avait le temps d’absorber un neutron de plus et, au lieu de fissionner, de se transformer dans 30% des cas en plutonium 240 d’une durée de vie de 6 500 ans. Les physiciens s’attendaient à ce qu’il soit beaucoup plus spontanément fissile que le 239, par analogie avec l’uranium 238 car tous les deux ont un nombre pair de protons et de neutrons. La mauvaise nouvelle était l’ampleur inattendue, et considérable, de cette fission spontanée.

| Noyau | U 235 | U 238 | Pu 239 | Pu 240 |

|---|---|---|---|---|

| Neutrons/kg/s | 0.01 | 13.6 | 22.0 | 920 000 |

Dans une bombe contenant 50 kg d’uranium 235, le taux de fission spontanée conduisait à un flux de 0.5 neutron par seconde, et le risque de prédétonation pendant la milliseconde de l’assemblage était quasi-nul. Si le processus d’enrichissement ne se révélait pas capable d’isoler de l’uranium 235 pur, le risque de prédétonation augmenterait : avec un enrichissement de 90% seulement, les 10% d’uranium 238 conduiraient à 70 neutrons/s. Mais le risque de prédétonation demeurait faible. Le risque était plus grand dans le cas du plutonium 239, avec ses 22 neutrons/kg/s, d’où la nécessité très tôt reconnue de rapprocher les masses sous-critiques en moins d’une milliseconde, et donc de recourir à un canon plus long.

Mais la contamination en plutonium 240 avec son taux de fission spontanée de près de un million de neutrons/kg/s, changeait la donne : même une très faible contamination de 0.1% de plutonium 240 conduirait à 10 000 neutrons/s pour les quelque 10 kg de plutonium nécessaires. Ces neutrons risquaient d’allumer prématurément la bombe même si le rapprochement des deux masses sous-critiques de plutonium ne durait que 100 µs. Pour corriger cela, il aurait fallu augmenter très fortement la vitesse de rapprochement en utilisant un canon de 20 (calcul ?) mètres de long. La bombe devenait alors beaucoup trop encombrante pour être emportée par un B-29. Ces conclusions furent momentanément gardées secrètes, en attendant plus de statistiques, et Segrè continua ses observations. Il confirma ses premières mesures pour le plutonium du réacteur X-10, et surtout il indiqua qu’il fallait s’attendre à un taux de fissions spontanées très supérieur dans le plutonium des réacteurs de Hanford, qui allait être exposé beaucoup plus longtemps à un haut flux de neutrons, et risquait de contenir 1 à 5% de plutonium 240.

Les réacteurs de Hanford étaient beaucoup trop avancés pour permettre un modification éventuelle de la production de plutonium, à supposer même qu’une idée soit trouvée évitant le problème de la fission spontanée. Il fallait « faire avec » le plutonium tel qu’il arriverait de Hanford. Oppenheimer fit part de ces conclusions le 4 juillet à ses collègues. Le « canon à plutonium » Thin Man fut abandonné le 17 juillet. Le 20 juillet, toute l’organisation de Los Alamos fut refondue et l’effort de développement se reporta sur Little Boy et sur Fat Man.

Enrico Fermi et Emilio Segrè en 1945

Mais, en juillet 1944, ces deux projets paraissaient l’un comme l’autre bien loin de pouvoir aboutir :

- il était pratiquement certain qu’une bombe comme Little Boy fonctionnerait du premier coup, mais quelques grammes seulement d’uranium 235 avaient pu être isolés ;

- il était pratiquement certain que les réacteurs de Hanford fourniraient assez de plutonium, mais il n’y avait pas de modèle fiable de bombe pour l’utiliser.

En effet aucune des méthodes d’enrichissement isotopique ne fonctionnait alors correctement à Oak Ridge : les calutrons de Y-12 n’avaient fourni que quelques grammes d’uranium 235, le bâtiment de K-25 était à moitié terminé mais les barrières poreuses n’étaient pas au point, et la décision de construire S-50, l’usine de séparation thermique, dut être prise en catastrophe. Dans les hypothèses les plus optimistes, Oak Ridge fournirait à peine de quoi faire une seule bombe à l’été 1945 (et peut-être une seconde à la fin de l’automne) et l’intérêt militaire d’une bombe unique semblait réduit.

Par ailleurs, les essais d’implosion avaient des résultats désastreux : toutes les tentatives de placer des charges explosives tout autour d’une sphère métallique conduisaient à une déformation inacceptable de cette sphère au lieu de la comprimer en conservant sa forme sphérique. Différentes tentatives d’intercaler des zones neutres entre les explosifs (pour réduire la formation de jets quand les détonations fusionnaient) échouèrent. De ce fait, il semblait impossible d’approcher de la masse critique. Les équipements de diagnostic étaient insuffisants (on utilisa ensuite des caméras ultrarapides à rayons X).

Los Alamos 1944 ©LANL

Au cas où Los Alamos ne trouverait pas de solution, Arthur Compton réunit à Chicago les principaux membres du Met Lab pour trouver une issue. Wigner proposa de fissionner le plutonium et d’utiliser les neutrons de la fission pour convertir du thorium 232 en uranium 233, que l’on pourrait extraire chimiquement du thorium. L’uranium 233 est fissile comme l’uranium 235 et le plutonium 239 et il permettrait de réaliser une bombe. L’idée inquiéta Conant qui se demanda si les Allemands ne pouvaient pas avoir eu la même et s’être déjà lancés dans une bombe à l’uranium 233. Seaborg indiqua que l’uranium 233 risquait toutefois d’être contaminé en uranium 232, sans doute aussi spontanément fissile mais surtout radioactif alpha (imposant donc de se débarrasser de toute impureté capable de générer des neutrons par bombardement alpha). Le convertisseur proposé par Wigner ne fut pas nécessaire, mais il eut une grande influence car c’était le premier projet détaillé de réacteur modéré et refroidi par eau légère. La « voie du thorium » est toujours d’actualité, en particulier en Inde qui possède de grandes réserves de thorium.

Crise

Au cours de l’été 1944, l’avenir du programme Manhattan parut donc très compromis : non seulement les deux méthodes envisagées pour réaliser une bombe se heurtaient chacune à des difficultés immenses, mais en plus sa nécessité militaire semblait s’estomper :

- des indications convergentes montrait que le programme nucléaire allemand était très en retard sur le programme américain et ne conduirait pas à une bombe avant la fin de la guerre en Europe. Dès janvier 1944, les services d’espionnage britanniques s’étaient convaincus que le programme allemand avait très peu avancé, mais les services américains n’étaient pas convaincus et ils mirent sur pied les missions Alsos, d’abord en Italie, puis en France et enfin en Allemagne. Le 10 juin, Bush reçut des indications qu’il y avait peu de risques de bombe allemande. Cela fut confirmé lorsque Pasch et Goudsmit rencontrèrent Joliot à Paris fin août, et définitivement assuré en arrivant à Strasbourg fin novembre. Weizsäcker en était parti, mais les documents laissés montraient la stagnation des recherches allemandes depuis 1942 : la possibilité même d’une réaction en chaîne n’était pas établie ! Les États-Unis n’imaginèrent jamais qu’il y ait pu y avoir un programme japonais ;

- les Américains progressaient rapidement dans le Pacifique (conquête des Mariannes en juillet, débarquement aux Philippines et anéantissement de la Marine Impériale Japonaise à Leyte en octobre, sans compter le très efficace blocus du Japon par la guerre sous-marine);

- les débarquements de Normandie en juin et de Provence en juillet avaient permis aux Alliés de progresser rapidement en France et de se rapprocher de l’Allemagne, tandis que l’Armée Rouge avança profondément de juin à août sur le front de l’Est, lors de l’opération Bagration, et elle se trouvait désormais à 500 km à peine de Berlin.

Les territoires contrôlés par l’Allemagne (en bleu) et par les Alliés (en rouge) en septembre 1944

Mais les dépenses engagées dépassaient très largement alors le milliard de dollars, les physiciens étaient stimulés par ces problèmes et ils avaient envie de les résoudre, les militaires rêvaient d’une arme exceptionnelle, et les politiques envisageaient déjà l’après-guerre comme un équilibre plus ou moins glacial avec l’URSS. Le 7 août 1944, Groves annonça à Stimson qu’une bombe à l’uranium ne serait prête qu’autour du 1° août 1945 (et peut-être une ou deux de plus avant la fin de 1945), et que, si les expériences se déroulaient bien, une bombe au plutonium pourrait aussi être prête en même temps (avec un rythme de livraison plus rapide, une par mois). Il était probable que la guerre serait alors terminée en Europe, ce qui signifiait que les bombes nucléaires seraient destinées au Japon, comme cela avait envisagé par le Military Policy Committee dès mai 1943. Groves déclara par la suite que, dans son esprit, il avait toujours été clair que l’arme nucléaire était avant tout dirigée contre le Japon (plus que contre l’Allemagne, en particulier pour une question de calendrier), mais également contre les Russes. Pour toutes ces raisons, le programme Manhattan ne fut pas ralenti mais au contraire intensifié.

Même les scientifiques les plus hauts placés ne furent pas avertis de l’absence de risque de bombe allemande : Bethe ne le sut qu’en mars 1945, neuf mois après Bush ! Le 20 juillet, la direction de los Alamos décida une réorganisation complète du travail à Los Alamos, en lui donnant pour priorité absolue la mise au point d’un mécanisme d’implosion fiable. En 15 jours, tout fut réorganisé autour de l’implosion et de Fat Man, Little Boy recevant une priorité secondaire puisque la bombe elle-même ne posait pas de problème particulier et que la fourniture d’uranium 235 n’était pas du ressort de Los Alamos. Le personnel à Los Alamos passa d’environ 1 100 en mai à plus de 2 500 un an plus tard ( ?). De fait le programme nucléaire accéléra début 1945 (avec la résolution des problèmes liés à la séparation de l’uranium 235, et la résolution du problème de l’implosion), et plus encore après le 8 mai 1945 : Oppenheimer dit que le rythme ne fut jamais aussi intense à Los Alamos qu’entre mai et août 1945 !

Réorganisation

Oppenheimer était désormais assisté de deux directeurs-adjoints, Fermi et Parsons. La division de théorie restait sous la direction de Hans Bethe et ses 5 groupes passèrent progressivement à 8 :

- T-1 : dynamique de l’implosion (Rudolf Peierls)

- T-2 : théorie de la diffusion (Robert Serber)

- T-3 : efficacité (Victor Weisskopf)

- T-4 : problèmes de diffusion (Richard Feynman)

- T-5 : calculs numériques (Donald Flanders)

- T-6 : calculs numériques sur IBM (Stanley Frankel et Eldred Nelson) en septembre 1944

- T-7 : dommages (Joseph Hirschfelder) en novembre 1944

- T-8 : arme composite (George Placzek) en mai 1945

La division expérimentale de Bacher devint la Research Division, sous la direction désormais de Robert R. Wilson, mais sans grand changement :

- R-1 : cyclotron (sous la responsabilité directe de R.R. Wilson)

- R-2 : générateurs électrostatiques (John H. Willams)

- R-3 : sources D-D (John Manley)

- R-4 : radioactivité (Emilio Segrè)

Une division F (comme Fermi) avait la charge des divers projets sans implication sur l’objectif principal : réaliser une bombe très vite. Sous la direction de Fermi, elle avait 4 groupes :

- F-1 : la « Super » (Teller)

- F-2 : LoPo (Lionel Daniel Percival « Perc » King)

- F-3 : expérimentation pour la « Super » (Egon Bretscher)

- F-4 : études de fission (Herbert Anderson)

La division Ordnance fut éclatée en trois divisions : O (Ordnance, s’occupant de Little Boy) sous l’autorité de Francis Birch (supervisé par Parsons), G (Weapon Physics, mais le G était là pour Gadget, en charge de la conception finale de Fat Man) dirigiée par Bacher et X (eXplosives) dirigée par Kistiakowsky. Chacune avait une dizaine de groupes. La division Chimie-Métallurgie prit aussi plus d’ampleur avec 16 groupes. S’ajoutèrent deux autres divisions, l’une en mars 1945 sous la direction de Bainbridge pour préparer Trinity, l’autre également en mars sous l’autorité directe de Parsons, assisté de Ramsey, pour gérer le projet Alberta.

Conant shipped as many scientists as could be spared from Chicago and Oak Ridge to Los Alamos, hired every civilian machinist he could lay his hands on, and arranged for Army enlisted men to supplement the work force (these GIs were known as SEDS, for Special Engineering Detachment). Hartley Rowe, an experienced industrial engineer, provided help in easing the transition from research to production. Los Alamos also arranged for a rocket research team at the California Institute of Technology to aid in procurement, test fuses, and contribute to component development. These changes kept Los Alamos on track as weapon design reached its final stages.

Masse critique: "chatouiller la queue du dragon"

Calcul théorique : la masse critique dépend de la géométrie (sphère pleine, sphère creuse, cylindre plein, cylindre creux) et de la densité. Pour une sphère pleine homogène, elle varie comme l’inverse du carré de la densité : l’implosion permet d’économiser beaucoup de matière fissile en augmentant fortement la densité, ce que suggèrent en octobre 1943 Teller et von Neumann

Plus précisément M = m3n3/2/(fσ3ρ2) où m est la masse du noyau, n le nombre de diffusions par fission, ρ la densité, σa section efficace de capture et f un fudge factor dépendant de la géométrie