Alain Bouquet - Le programme Manhattan

5 - Comment faire une bombe en 1942

<Attention: ces pages ne sont plus mises à jour car le site a déménagé. Il se trouve désormais à: Pensez à mettre à jour vos signets et bookmarks! |

Champs, Noyaux & particules

Radioactivité

Noyaux, protons et neutrons

- Noyau atomique: Rutherford

- Noyau atomique: Bohr, Soddy et Moseley

- Noyau atomique: Aston et Rutherford

- Neutron: Chadwick

- Neutron: Joliot-Curie

- Neutron: Fermi

Intruments, accélérateurs et détecteurs

Mécanique quantique

- Mécanique ondulatoire

- Formalisme quantique

- Applications

- Théorie quantique des champs

- Électrodynamique quantique

Fission nucléaire

Fusion nucléaire

Particules en tout genre

- Le "Summer Study" de Berkeley

- Une bombe à fission

- Les concepts de base d'une bombe nucléaire

- Et la fusion ?

- Conclusions du Summer study

Le "Summer Study" de Berkeley

En février 1942, Arthur Compton avait demandé à Gregory Breit de prendre en charge à Chicago les aspects théoriques du programme d’arme nucléaire. La physique des neutrons rapides était un domaine presque inexploré, et des recherches poussées étaient indispensables pour éviter que le programme s’engage dans une impasse. Il était en effet tout à fait possible que la découverte de phénomènes inattendus remette en cause tout le programme. Et la rareté et la qualité médiocre des données expérimentales disponibles étaient de toute manière un obstacle majeur, même en l’absence de nouvelles difficultés. Breit lança donc différents programmes de recherche théorique sur la séparation isotopique, la diffusion des neutrons et les réactions en chaîne. Des petits groupes de théoriciens travaillèrent sur ces questions dans les universités de Berkeley, Stanford, Rice, Chicago, Purdue, Harvard, Princeton, Cornell, du Wisconsin, du Minnesota et au Département de magnétisme terrestre de la Fondation Carnegie à Washington. Cependant Compton n’avait guère accordé d’autorité ni de moyens à Breit, et cet aspect du projet global n’avait qu’une faible priorité. Breit démissionna de son poste dès le 18 mai, trouvant les progrès trop lents (une des raisons de cette lenteur était l’accent sans doute excessif mis par Breit sur la sécurité, freinant les échanges d’informations). Compton demanda à Oppenheimer de prendre la suite le 11 juin. Qui soutenait alors Oppenheimer (Compton, Lawrence ?) et qui s’inquiétait de son manque d’expérience (Conant ?).

Gregory Breit (1899-1981)

J. Robert Oppenheimer avait montré beaucoup d’intérêt pour la fission quand la nouvelle était arrivée aux États-Unis, au point d’esquisser immédiatement un schéma de bombe, mais il travaillait alors plutôt sur l’implosion gravitationnelle et les trous noirs avec son étudiant George Volkoff. En octobre 1941 toutefois, à la demande de Lawrence et de Compton qui s’inquiétaient de la lenteur des progrès américains en physique nucléaire, Oppenheimer reprit la question de la diffusion des neutrons rapides. En décembre 1941, il demanda à son ancien post-doc Robert Serber (alors à l’université de l’Illinois à Urbana) de revenir à Berkeley, où il n’arriva qu’en avril 1942 au terme de son enseignement, pour étudier la question de la diffusion des neutrons dans l’uranium 235 (problème assez différent de la diffusion étudiée par Wigner et son groupe à Chicago). Serber récupéra deux post-docs, Eldred Nelson et Stanley Frankel, qui calculaient pour Lawrence des orbites pour le calutron. Ils partirent du mémorandum de Frisch et Peierls, du rapport MAUD et du rapport Compton. Dans ses souvenirs, Serber dit qu’il n’existait alors – à sa connaissance – aucun travail américain sur l’estimation de la masse critique (en dehors des esquisses du rapport Compton fortement inspiré des travaux britanniques).

Nelson et Frankel améliorèrent les estimations britanniques qui utilisaient (semble-t-il, mais Peierls avait bien écrit une équation intégrale) l’approximation de la diffusion, qui devient insuffisante quand le libre parcours moyen est du même ordre que la taille du système. Serber dit que Nelson et Frankel établirent l’équation intégrale exacte et la résolurent par la méthode de Wiener-Hopf (mais certainement en se limitant au cas sphérique et pour une seule vitesse des neutrons, cf. infra).

Breit, Oppenheimer et leurs collaborateurs réduisirent l’incertitude sur la masse critique de l’uranium 235 à une fourchette de 2 à 5 kg (le rapport Compton donnait un large intervalle de 2 à 100 kg) qui se révéla fortement sous-estimée. Ils se montrèrent également exagérément optimistes sur la capacité de la fission à progresser avant que la bombe soit disloquée, et ils surestimèrent donc le rendement de celle-ci. Ils abordèrent également l’hydrodynamique de l’explosion et la manière dont l’énergie libérée serait diffusée dans l’environnement. Dans une lettre du 19 mai 1942 à Lawrence, Oppenheimer estimait que le problème de construction d’une bombe était théoriquement résolu, et qu’une « petite équipe de six bons physiciens » pourrait régler le reste des détails pratiques en six mois. Son optimisme venait de l’idée que, une fois l’uranium 235 ou le plutonium 239 disponibles, un simple assemblage de deux masses critiques par un « canon » suffirait à réaliser une explosion nucléaire. Il n’avait pas entièrement tort, dans la mesure où les principes de base d’une arme nucléaire étaient plutôt bien compris. Par contre, personne parmi les théoriciens n’avait réellement conscience des très nombreuses difficultés techniques qui allaient se présenter, ni de l’ampleur du programme industriel requis.

J. Robert Oppenheimer en 1943

Summer Study

Rappel : Roosevelt donna le 18 juin 1942 le feu vert au programme Manhattan.

Les 5 et 6 juin 1942, Oppenheimer se rendit au Met Lab à Chicago pour rencontrer les physiciens, théoriciens et expérimentateurs, et faire le point des travaux en cours. À ce moment-là, il envisageait que les théoriciens de Berkeley, comme Serber, Frankel et Nelson collaborent étroitement avec les expérimentateurs du Rad Lab à Berkeley comme McMillan, Kennedy et Segrè, et que les théoriciens de Chicago comme Teller, Christy ou Konopinski collaborent avec les expérimentateurs du Met Lab comme Manley. Ultérieurement il les rassembla tous à Los Alamos.

| Di | Lu | Ma | Me | Je | Ve | Sa |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | |||

| 5 | 6 | 7 | 8 | 9 | 10 | 11 |

| 12 | 13 | 14 | 15 | 16 | 17 | 18 |

| 19 | 20 | 21 | 22 | 23 | 24 | 25 |

| 26 | 27 | 28 | 29 | 30 | 31 |

Calendrier de juillet 1942

Mais auparavant, il jugea utile de réunir (presque) tous les théoriciens pour étudier concrètement un projet de bombe. Il plaça la réunion au Département de physique de Berkeley, estimant les conditions de travail meilleures qu’à Chicago en été. Cette réunion, connue sous le nom de Berkeley Summer Study commença la deuxième semaine de juillet. Apparemment la première semaine fut la plus intense (Oppenheimer en fit le compte-rendu à Manley dans une lettre du 14 juillet), mais la réunion s’étira sur près de 6 semaines, avec des interruptions nombreuses dues aux déplacements des uns ou des autres (à Chicago en particulier). Les discussions se tinrent le plus souvent dans une salle située à côté du bureau d’Oppenheimer, au dernier étage de LeConte Hall, siège du Département de physique de l’Université de Berkeley. Les spéculations allèrent bon train, et les participants en gardèrent un souvenir ébloui.

LeConte Hall, siège du Département de physique de l’Université de Californie à Berkeley

Parmi les participants se trouvaient Hans Bethe, Felix Bloch, Emil Konopinski, Robert Serber, Robert Tolman, Edward Teller, et John Van Vleck. Certains expérimentateurs de Berkeley, comme Luis Alvarez (il n’était pas au MIT sur les radars ?), J. Lawson, Robert Thornton et Robert Becker participèrent à certaines des discussions. Teller avait eu Heisenberg comme directeur de thèse, Bloch avait été son assistant, et Bethe lui avait succédé comme assistant d’Heisenberg avant de s’expatrier à son tour.

Wheeler n’était pas là. Professeur depuis 1938 à Princeton (Feynman y soutint son PhD en juin 1942), il avait rejoint le groupe de Wigner au Met Lab de Chicago en janvier 1942 pour réaliser un réacteur fabriquant du plutonium, avant de quitter Chicago pour Wilmington (siège de DuPont) en mars 1943 puis pour Hanford en juillet 1944.

Felix Bloch (1905-1983), d’origine suisse (ETH avec Debye et Weyl puis Zürich avec Schrödinger), avait passé son doctorat (ondes de Bloch) à Leipzig avec Heisenberg en 1928. Il collabora avec Pauli à Zürich, Bohr à Copenhague, Fermi à Rome, devint privatdozent à Leipzig « sous » Heisenberg, avant de quitter l’Allemagne en 1933 pour devenir professeur de physique théorique à Stanford. Naturalisé américain en 1939, il participa brièvement au programme Manhattan à Los Alamos avant de rejoindre Harvard pour travailler sur le radar. Il travailla ensuite sur la résonance magnétique nucléaire, qui lui valut le prix Nobel de physique en 1952. Il fut le premier directeur du CERN en 1955.

Emil Konopinski (1911-1990), professeur de physique à l’université d’Indiana, travailla à Chicago avec Fermi au premier réacteur nucléaire avant de rejoindre Los Alamos. Il collabora avec Teller sur les questions de fusion.

Robert Serber (1909-1997) fit son doctorat avec Van Vleck en 1934 avant de devenir post-doc d’Oppenheimer, puis professeur à l’université de l’Illinois à Urbana. Il joua un rôle majeur dans le programme Manhattan, en particulier en formant les nouveaux arrivants à Los Alamos sur les objectifs de leur travail (le Los Alamos Primer), et en faisant progresser les méthodes de calcul du transport des neutrons (méthode de Serber-Wilson). Il fut l’un des premiers physiciens à pénétrer à Hiroshima et Nagasaki en septembre 1945. Après la guerre, il rejoignit Lawrence à Berkeley avant de devenir professeur à Columbia.

John Van Vleck (1899-1980) fils de mathématicien et petit-fils d’astronome, fut professeur au Wisconsin puis à Harvard et l’un des fondateurs de la théorie quantique du magnétisme (qui lui valut le prix Nobel de physique en 1977). Pendant la guerre, il se partagea entre Harvard et le MIT (travaux sur les radars). Après le Summer Study, il participa à plusieurs des comités supervisant le programme Manhattan.

21 juin, prise de Tobrouk par l’Afrika Korps, arrêtée du 1° au 27 juillet à (la première bataille d’) El Alamein, 28 juin offensive allemande (Fall Blau) vers le Don et la Volga, et vers le pétrole du Caucase, 3 septembre, début de la bataille de Stalingrad ; 16 juillet, rafle du Vel’ d’Hiv’ ; 19 août échec du raid sur Dieppe

L'offensive allemande de l'été 1942 vers le Caucase et Stalingrad (Plan bleu ou Fall Blau)

Situation dans le Pacifique à l'été 1942:1° mai, bataille de la mer de Corail, 7 juin 1942 invasion japonaise des Aléoutiennes, du 4 au 7 juin victoire américaine de Midway , 7 août 1942, débarquement des marines et début de la bataille de Guadalcanal, 9 août, victoire navale japonaise à Savo dans les Salomon.

Une bombe à fission

Comme le dit très clairement le Los Alamos Primer :

The object of the project is to produce a practical military weapon in the form of a bomb in which the energy is released by a fast neutron chain reaction in one or more of the material known to show nuclear fission.

Chaque fission libère 170 MeV, soit 3.2x10-11 joules/noyau ou encore 88 TJ/kg d’uranium 235. La fission d’un kilo d’uranium libère l’équivalent de 20 000 tonnes de TNT (1 kg de TNT libère 4.2 MJ, ou 4.6 selon les sources).

San Francisco dans le lointain (le Bay Bridge sur la gauche, le Golden Gate sur la droite) et au premier plan le campus de l’université de Berkeley (LeConte Hall est juste devant et à droite du clocher de la Sather Tower)

L’objectif principal du groupe d’étude rassemblé par Oppenheimer était d’esquisser un projet réaliste de bombe à fission :

- quelle quantité d’uranium ou de plutonium faudrait-il,

- quelle géométrie adopter pour assurer un rendement suffisant de l’explosion tout en évitant un allumage prématuré,

- quel réflecteur à neutrons (tamper) choisir pour réduire la masse critique,

- quelle énergie serait libérée et sous quelle forme ?

Aussi importante était la liste des étapes à accomplir avant d’aboutir à la bombe et l’identification des étapes clés conditionnant la réussite — ou l’échec — du projet.

Concrètement, le point de départ des réflexions était formé par le mémorandum de Frisch et Peierls de mars 1940, le rapport MAUD de juillet 1941, le rapport final de Compton de novembre 1941, les études de Breit et d’Oppenheimer du printemps 1942, et les travaux encore inachevés de Nelson et Frankel sur l’estimation la masse critique et ceux de Serber sur l’onde de choc dissociant la bombe et stoppant la réaction, « l’onde de choc de Serber » comme on l’appela un temps. Dans la théorie classique de la diffusion, on suppose que le libre parcours moyen est petit par rapport à la taille du système (diffusion de proche en proche), mais le libre parcours moyen des neutrons est du même ordre de grandeur que la taille critique. Par conséquent, une théorie correcte de la diffusion des neutrons dans une réaction en chaîne explosive doit tenir compte de la densité de neutrons en tout les points du volume : Nelson et Frankel aboutirent donc à une équation intégrale, qui s’avéra impossible à résoudre analytiquement de manière exacte.

La réunion commença la deuxième semaine de juillet par une revue de ces rapports, puis Serber, Nelson et Frankel présentèrent leurs travaux du printemps. Bethe se rappelle que le groupe valida leur conclusion qu’une sphère d’uranium 235 de 9 cm de rayon permettrait une réaction en chaîne explosive.

Beaucoup de données cruciales étaient encore fragmentaires, ou contradictoires. Le groupe reconnut qu’une bombe n’était envisageable qu’avec une fission rapide, car avec une fission lente elle serait immédiatement dissociée avant que la réaction en chaîne ait beaucoup progressé. À ce moment là, seule la section efficace de fission lente de l’uranium 235 (par des neutrons thermiques) avait été mesurée, autour de 640 barns. En extrapolant la loi en 1/V, on pouvait espérer que la section efficace de fission rapide tourne autour du barn. Beaucoup de discussions portèrent sur cette valeur clé, mais elle ne fut à peu près connue qu’au printemps 1943.

Serber (?) suggéra que l’assemblage de deux masses sous-critiques était réalisable au moyen d’un canon. La discussion porta sur la possibilité de réaliser un canon capable d’assembler les deux masses assez rapidement pour éviter une prédétonation due aux neutrons errants. Puis fut examinée fut la physique de l’explosion d’une telle bombe, une évaluation de son efficacité et une estimation des dégâts qu’elle pourrait provoquer. En estimant l’efficacité à quelques % au mieux, ils extrapolèrent les dommages de l’explosion de Halifax, au Canada, le 6 décembre 1917, au cours de laquelle le cargo Mont-Blanc chargé de 2 400 tonnes de munitions explosa à la suite d’une collision avec un autre navire dans le chenal d’entrée du port, tuant 2 000 personnes (et faisant 9 000 blessés dont 2/3 de blessés graves) et détruisant 2.5 km2 de la ville. Les participants relevèrent qu’une bombe nucléaire ajouterait à l’effet de souffle un rayonnement de neutrons et de gammas et un rayonnement thermique.

Le port de Halifax ravagé par l’explosion en décembre 1917

En discutant du plutonium, les participants calculèrent le nombre de neutrons parasites résultant de particules alpha entrant en collision avec des impuretés dans le plutonium, comme du béryllium, de l’aluminium ou du silicium, et ils évaluèrent le risque d’une prédétonation. Ils reconnurent la nécessité d’un assemblage plus rapide que pour l’uranium, ce qui impliquait un canon plus long, donc plus lourd. Ils estimèrent la durée de la fission à une microseconde, et ils discutèrent de l’effet de la vaporisation du cœur sur la fission.

Au bout de deux jours, la majorité des participants estima que les problèmes techniques étaient, sinon résolus, du moins assez bien cernés et que peu de progrès seraient possibles avant de disposer de données plus fiables. L’intérêt se porta alors sur l’esquisse de bombe thermonucléaire avancée par Teller (cf. infra). Les « seniors » étant occupés par ces projets grandioses de « Super », ce sont les « juniors » qui s’impliquèrent le plus dans les détails d’une bombe à fission.

Les concepts de base d'une bombe nucléaire

Serber et Oppenheimer (à Berkeley en 1946) © Corbis

Une réaction en chaîne dans l’uranium 235 ou le plutonium 239 presque purs est très différente de celle qui se déroule dans l’uranium naturel d’un réacteur :

- Les matériaux sont fissiles quelle que soit l’énergie du neutron

- Aucun modérateur ne ralentit les neutrons (seuls les chocs – peu efficaces – sur l’uranium ou le plutonium les ralentissent), et ceux-ci sont relativement peu absorbés (comparer les sections efficaces fission% absorption% diffusion) : fission 1.5 barn, total 4 barns

- Échelle de temps plus courte entre deux fissions (il n’y a pas la dizaine de collisions ralentissant le neutron avant qu’il provoque une fission)

- Multiplication exponentielle du nombre de fissions (régime supercritique) : on n’est PAS en régime stationnaire ! 99% de l’énergie est libérée à la fin de la réaction (effet de l’exponentielle !) donc les neutrons qui tardent à réagir (parce qu’ils subissent des collisions ou qu’ils sont renvoyés par le réflecteur) contribuent peu à la réaction en chaîne. Donc le réflecteur ne sert pas vraiment à diminuer la masse critique mais seulement à freiner l’expansion du matériau fissile pour qu’une fraction plus importante fissionne. Pas totalement juste : le libre parcours moyen est plus grand que la taille critique, et le réflecteur diminue les pertes de neutrons.

D’un côté, le problème est plus simple que pour le réacteur, car on a un matériau homogène, de l’autre il est plus compliqué car on a une explosion (=non stationnaire) avec ondes de choc, etc.

Paramètres de la fission

Un neutron pénétrant dans une région d’uranium 235 pur avec une énergie de 1 MeV, typique d’un neutron produit par fission, parcourt quelques centimètres (son libre parcours moyen) avant d’entrer en collision avec un noyau d’uranium et de rebondir, en perdant peu d’énergie du fait de la grande différence de masse entre projectile et cible. Il subit en moyenne cinq ou six de ces collisions quasi élastiques avant de provoquer une fission (section efficace de fission ~ 1 mb, de collision ~ 6 mb), ayant ainsi parcouru moins d’une dizaine de centimètres. À 1 MeV, sa vitesse est de 14 000 km/s et les fissions sont donc séparées de quelques nanosecondes seulement.

Sections efficaces de l’uranium 235

Sections efficaces du plutonium 239

Section efficace de fission rapide estimée à 1.5 barn pour l’uranium 235 et à 3 barn pour le plutonium 239 (en fait 1.2 et 1.8). Énergie moyenne des neutrons de 2 MeV (maxwellienne), nombre moyen de neutrons alors mal connu (estimé à 2.2±0.2, en fait 2.4) pour l’uranium 235, et inconnu pour le plutonium 239, donc pris égal à celui de l’uranium (en fait il est proche de 3). On ne savait pas non plus si le nombre de neutrons/fission variait ou non avec l’énergie du neutron incident.

Masse critique

Estimer la masse critique était absolument crucial pour prévoir la quantité de matériel « actif » nécessaire pour chaque bombe et pour pouvoir déterminer la taille requise des usines de séparation isotopique, des réacteurs de production du plutonium et des usines de séparation chimique : sous-estimer leur taille d’un facteur 10 les rendrait inutiles, surestimer leur taille d’un facteur 10 conduirait à des coûts encore plus extravagants.

Équation de la distribution des neutrons dans une sphère homogène de rayon R.

Si N est la densité de neutrons en un point, ν le nombre de neutrons secondaires par fission et τ l’intervalle entre deux fissions ( τ = 1/[nσfV] ), on a :

dN/dt = – div J + (ν-1)N/τ

où J est le courant de neutrons. SI le libre parcours moyen est beaucoup plus petit que la taille du système étudié, on peut utiliser la théorie classique de la diffusion et le courant J est simplement proportionnel au gradient local de la densité N : J = -D grad N.

Le coefficient de proportionnalité D = λV/3 est le coefficient de diffusion (V étant la vitesse moyenne des neutrons et λ étant le libre parcours moyen entre 2 collisions, pas deux fissions, donné par λ = 1/nσt où n est la densité de noyaux et σt la section efficace totale des neutrons). Pour l’uranium 235, σt ~ 7 barns, n = XX cm-3 et donc λ ~ 5 cm. Dans l’approximation de la diffusion, on doit donc résoudre l’équation classique (équation de la chaleur de Fourier) :

dN/dt = – DΔN + (ν-1)N/τ

On cherche une solution à symétrie sphérique et exponentielle dans le temps de la forme N = N(r) exp{ν’t/τ}. Cela donne une équation différentielle (dépendant de ν’) pour N(r) :

ΔN + [(-ν’+ν-1)/Dτ] N = 0

dont la solution est N(r) = sin(πr/R)/r en utilisant comme condition aux limites que la densité de neutrons s’annule à la surface de la sphère, i.e. pour r = R.

Laplacien en coordonnées sphériques [pour une symétrie sphérique f(r,θ,φ) = f(r) ] : Δf = f ‘’ +2f ’/r . C’est la même forme en coordonnées cylindriques, si f(r,θ,z) = f(r) .

Ceci implique ν’ = ν – 1 – π2Dτ/R2.

Pour une sphère de très grande taille (R→∞) la densité de neutrons augmente exponentiellement selon ν-1 (le -1 vient car un neutron disparaît à chaque fission). Pour une sphère plus petite, l’augmentation est plus lente, et pour une sphère dont le rayon R conduit à ν’<0, les pertes à travers la surface sont telles que la densité de neutrons diminue exponentiellement.

La taille critique correspond donc à ν’=0, soit :

Rc = π [Dτ/(ν-1)]1/2

Comme τ = 1/(nσfV) et D = λV/3 = V/(3nσt) cela donne Rc = π /[(ν-1) 3nσt nσf]1/2 = π/{n/[3(ν-1) σt σf]1/2 }}

La masse critique est Mc = 4πρRc3/3 où ρ = m n est la densité (massique) de l’uranium. D’où enfin

Rc = π/{n/[3(ν-1) σt σf]1/2 }

Mc = {4 π4 / 9√3 } m3 / { ρ2 [ (ν-1) σt σf]3/2 } ∝ [ (ν-1) σt σf] –3/2 / ρ2

Ce calcul simple (simpliste) donne un rayon critique de l’ordre de 13.5 cm et une masse critique d’uranium de 200 kg.

Pour le plutonium, avec des sections efficaces ~2 fois plus grandes, la masse critique est 23 = 8 fois plus faible. Une erreur de 50% sur la section efficace conduit à une erreur d’un facteur 3 sur la masse critique Les densités de l’uranium 235, et plus encore du plutonium 239, étaient mal connues, et on ne savait pas que le plutonium avait plusieurs phases de densité différentes. Une erreur sur la densité, de 15 à 20 g/cm3 par exemple, change la masse critique d’un facteur presque 2 !

Serber donne en exercice de résoudre l’équation différentielle pour une configuration cubique d’arête a, et de démontrer que l’arête critique ac = √3 Rc, , ce qui donne une masse critique 24% plus grande que celle d’une sphère. Et pour un cylindre ?

Dans le Los Alamos Primer, en avril 1943, Serber ne fait aucune remarque sur l’intérêt d’augmenter la densité ρ pour diminuer la masse critique. Apparemment l’idée ne viendra que plus tard, sans doute à Teller fin 1943 ou début 1944.

Le libre parcours moyen étant comparable à la taille du système, l’approximation de diffusion n’est en réalité pas valable. Le flux de neutrons en un point ne dépend pas du flux de neutrons juste à côté mais du flux en tous les points de la masse. L’équation correcte est donc une équation intégrale, faisant intervenir la densité de neutrons en tous les points. Écrire cette équation n’est pas difficile, c’est un cas particulier de l’équation de Boltzmann, mais elle n’est soluble que dans des cas extrêmement simplifiés.

Difficultés additionnelles :

- les neutrons n’ont pas tous la même vitesse (la pratique fut de les répartir en N « groupes » de même vitesse et de résoudre le système de N équations couplées).

- leur vitesse varie lors des collisions.

- les sections efficaces dépendent des vitesses (et elles ne sont pas vraiment isotropes).

- la densité varie au cours du temps pendant l’explosion.

- le matériau fissile et le réflecteur n’ont pas les mêmes propriétés nucléaires (libre parcours moyen en particulier) ni mécaniques ni thermiques.

Même avec toutes les hypothèses simplificatrices, il n’y a pas de solution analytique dès que la géométrie n’est pas sphérique (ou un plan infini [slab]).

L’équation intégrale pour la densité N de neutrons (Frankel et Nelson, rapport LA-8 mai 1943), 1+f est le nombre de neutrons émergeant d’une collision (pas nécessairement une fission) et σ la section efficace totale par unité de longueur.

Dans le Los Alamos Primer, Serber dit juste que l’approximation de diffusion surestime de 50% rayon et masse critiques, et que le rayon critique pour l’uranium 235 pur fut estimé à 9 cm pour une sphère homogène, d’où une masse critique de 60 kg. Pour le plutonium, du fait de sa section efficace deux fois plus grande, la masse critique était estimée entre 10 et 20 kg. Les méthodes de calcul étaient cependant inadéquates pour des formes plus complexes qu’une sphère homogène, un cylindre de longueur finie par exemple, ou une sphère creuse. Les masses critiques étaient certainement plus grandes, mais était-ce d’un facteur 2 ou d’un facteur 10, personne ne pouvait alors répondre à la question.

Par ailleurs, il est important de noter que le temps effectif de divergence exponentielle pour une sphère de rayon R>Rc n’est pas τ, il est plus long car il est donné par τ/[1-(Rc/R)2]

Tamper

Entourer le cœur par un réflecteur de neutrons, le « tamper », permet de diminuer le rayon critique de 30%, de 9 à 6 cm, diminuant la masse critique d’un facteur presque 4, de 60 à 15 kg pour l’uranium. Il demeurait plus d’incertitudes pour le plutonium, mais sa masse critique avec un tamper adéquat était estimée entre 5 et 10 kg. En fait, il était clair dès cette époque que l’effet de réflecteur était moins efficace que ce calcul l’indiquait, car les neutrons renvoyés par le réflecteur n’avaient pas beaucoup le temps de participer réellement au développement de la réaction en chaîne exponentielle. La masse critique n’était que peu diminuée. Mais le tamper avait une autre utilité : par son inertie, il freinait la dilatation du cœur et améliorait ainsi fortement l’efficacité de l’explosion. Le matériau optimal sur ces deux points est le plus dense possible, et l’emploi de l’or, du tungstène, du rhénium et de l’uranium lui-même (le 238 peut parfaitement servir de tamper, on ne lui demande pas de fissionner) fut envisagé. Comme le raconta l’un des participants (Serber ?), vaporiser plusieurs dizaines de kilos d’or ne parut alors bizarre à personne. La bombe d’Hiroshima utilisa du tungstène comme tamper (pour éviter le risque de neutrons venant de la fission spontanée de l’uranium), celle de Nagasaki utilisa de l’uranium.

Efficacité

Comme Frisch et Peierls deux ans plus tôt, les physiciens à Berkeley réalisèrent que le matériau fissile allait se dilater rapidement du fait de l’énergie libérée et arrêter ipso facto la réaction en chaîne. Cela implique qu’il faut déjà rassembler une masse M > Mcritique pour avoir ne serait-ce qu’un début d’explosion. Cette masse M a un rayon initial R0 et une densité initiale ?0. La masse critique varie comme l’inverse du carré de la densité, et la masse comme l’inverse du cube de la densité. Par conséquent, la réaction en chaîne s’arrête quand la dilatation amène le rayon à R = R0 [M/ Mcritique]1/6. Concrètement, cela veut dire que si l’on arrive à rassembler 2 masses critiques, la réaction en chaîne s’arrête quand le rayon est 21/6 = 1.12 le rayon initial. Les physiciens en avaient conclu qu’une dilatation d’un ou deux centimètres (12%) suffirait à rendre la masse sous-critique et à stopper la réaction en chaîne. À des températures de 40 MK, la matière se déplacerait à 108 cm/s : la fission serait donc arrêtée en 5x10-8 s (soit 5 étapes de fission, les dernières de la chaîne). D’où efficacité de l’ordre de 1/25 ~ 1 à 3%.

REVOIR LE CALCUL.

Little Boy eut une efficacité de 1.4% seulement, Fat Man atteignant 15% grâce à l’implosion qui ralentit l’expansion.

Énergie

Chaque fission libérant en moyenne 2.4 neutrons dont une petite fraction est perdue par capture ou par fuite, le nombre de neutrons — et de fissions — double pratiquement toutes les 10 nanosecondes. En 70 générations, ce sont donc près de (2.2)70 ~ 1024 fissions qui se produisent pour chaque neutron initial, libérant chacune 200 MeV (soit 3.2x10-11 J) : au total ce sont donc 3.2x1013 joules qui sont libérés, l’équivalent de 8 kilotonnes de TNT (1 kg de TNT libère 4.2 MJ).

En fait ce calcul est doublement erroné :

- d’une part, la réaction en chaîne est démarrée par un allumeur (mettant en contact 10 curies de polonium avec du béryllium dans les premières bombes) qui engendre une bouffée d’une dizaine de neutrons dans la première nanoseconde (F=10 Ci=3.7x1011 α/s, σ(α,Be9) ~ 250 mb, densité du béryllium 9 n=1.2x1022 noyaux/cm3, donc flux de neutrons Fσne~1.1x1010 neutrons/s pour e=1 cm de cible de béryllium) ;

- d’autre part, les « générations » de neutrons ne se succèdent pas réellement, elles se superposent.

Les deux effets se compensent en partie. La « descendance » des premiers neutrons qui provoquent une fission sont très vite beaucoup plus nombreux que celle des neutrons qui mettent plus de temps à en provoquer une (et cela se répète tout au long de la chaîne). La divergence exponentielle de la réaction en chaîne signifie également que l’essentiel de l’énergie est libérée à la fin de la réaction en chaîne, 99% dans les quatre ou cinq dernières étapes.

Effets d’une explosion nucléaire

Bethe et Teller effectuèrent aussi un calcul d’ordre de grandeur qui leur montra que l’essentiel de l’énergie engendrée par une explosion nucléaire serait émise sous forme de rayons X car la température atteindrait quelques 40 millions de degrés, et ils explorèrent qualitativement la transmission de ces rayons X dans l’atmosphère. Maria Goeppert-Mayer avait été encouragée à Columbia par Teller à examiner les effets d’une explosion nucléaire. En calculant l’opacité de l’uranium à haute température (??) et la manière dont il absorbait le rayonnement, elle avait trouvé que le rayonnement électromagnétique emportait une fraction de l’énergie beaucoup plus grande que pour une bombe classique. Son association avec Teller continua après la guerre à Chicago (ils étaient très proches, ce qui provoqua des ragots sans fondement). Cela leur donna une première idée des effets matériels d’une explosion nucléaire, en particulier le rôle très important du rayonnement thermique s’ajoutant à celui du souffle. Un raisonnement essentiellement dimensionnel montra que l’effet de choc allait diminuer comme le cube de la distance à l’épicentre, et l’effet thermique comme le carré. Celui-ci serait donc dominant à grande distance, et l’effet de souffle à courte distance. Et l’un comme l’autre seraient proportionnels à l’énergie libérée. Partant de l’effet d’une bombe classique (10 kg de TNT détruisent tout dans un rayon de 15 m), les physiciens estimèrent qu’une bombe de 10 kT détruirait tout dans un rayon de 1 500 m.

Assemblage

Le petit groupe aborda aussi le principe de la réunion de plusieurs masses sous-critiques pour provoquer l’explosion. Le problème était compliqué par la nécessité de réunir une masse qui, au final, devrait être de 3 à 4 masses critiques pour obtenir une efficacité raisonnable. Mais cette réunion prendrait nécessairement un temps non nul, et il y aurait par conséquent un intervalle de temps où la masse rassemblée serait supercritique, et donc susceptible d’exploser, mais sans avoir encore atteint la configuration optimale. Assembler un cœur fissile de quelques dizaines de centimètres de diamètre (3 ou 4 masses critiques) en projetant les masses sous-critiques les unes sur les autres par un explosif prendrait au moins 100 µs (10 cm/1000 m/s car un obus de canon ne dépasse guère les 1000 m/s). La durée totale d’une explosion nucléaire est beaucoup plus courte car il ne faut que 0.1 µs pour que se succèdent 100 générations de 10 ns, tout neutron traversant l’assemblage pendant la durée de l’assemblage risquait de provoquer une explosion prématurée.

Il est donc crucial qu’il y ait moins d’un neutron traversant la bombe pendant les 100 µs de l’assemblage final, soit un flux de neutrons inférieur à 10 000 neutrons/s.

Les trois sources possibles de neutrons parasites étaient les neutrons produits par les collisions de rayons cosmiques dans l’atmosphère, mais leur flux de 150 neutrons/s/m2 les rendait inoffensifs, les neutrons provenant d’impuretés dans l’uranium ou le plutonium, mais les chimistes pensaient parvenir à un taux de pureté suffisant, et les neutrons provenant de la fission spontanée de l’uranium ou du plutonium. Lors de la réunion de Berkeley, le flux de neutrons dus à la fission spontanée de l’uranium 238 avait déjà été mesuré, et il était de l’ordre de 15 neutrons/kg/s. Ceux de l’uranium 235 et du plutonium 239 n’avaient pas encore pu être mesurés et les physiciens ne disposaient que de limites supérieures : ce taux était inférieur à 150 neutrons/kg/s pour l’uranium 235, et inférieur à 500 neutrons/kg/s pour le plutonium 239. La théorie de Bohr et Wheeler permettait même de penser que le taux de l’uranium 235 serait nettement inférieur à celui de l’uranium 238, et celui du plutonium 239 un peu supérieur.

La situation paraissait donc satisfaisante : le flux attendu pour une bombe de 40 kg d’uranium serait certainement inférieur à 6 000 neutrons par seconde, et pour 10 kg de plutonium inférieur à 5 000 neutrons par seconde. Ce n’était pas très loin de la limite des 10 000 neutrons par seconde, mais cela parut jouable.

Robert Serber, peu après la Seconde guerre mondiale

Choisir l’uranium comme réflecteur compliquait quelque peu les choses, car s’il était le réflecteur le plus efficace, il en faudrait malgré tout environ une tonne, provoquant 15 000 neutrons par seconde. Bien sûr tous n’arriveraient pas jusqu’au cœur fissile, mais le risque de prédétonation était fortement accru. Utiliser à la place un autre métal très dense, comme le tungstène (19.3 g/cm3), serait préférable de ce point de vue. Le platine (21.4 g/cm3), l’iridium (22.6 g/cm3) ou l’or (19.3 g/cm3) pourraient aussi faire l’affaire, mais ils étaient plus chers : le platine coûte aujourd’hui 40 $/g, donc une tonne 40 M$_2009 soit 5M$_1943, l’or coûtait alors 34$ l’once (=31 g), soit 1.1$/g donc à peine plus d’un million de dollars pour le réflecteur de chaque bombe… Le plutonium posait un autre problème : étant fortement radioactif (émetteur alpha avec une durée de vie de 24 000 ans), il risquait d’engendrer des neutrons quand ces alphas bombarderaient l’environnement de la bombe, ou des impuretés présentent lors de l’isolement chimique. Or 10 kg de plutonium engendreraient 2.5x1013 alphas par seconde, et ces alphas à leur tour engendreraient les 10 000 neutrons/s critiques si par exemple du béryllium 9 se trouvait dans l’environnement au taux de 1 ppm, ou du carbone au taux de 200 ppm. Une extrême pureté du plutonium était donc requise.

Une fois réunie la quantité voulue de matériau fissile, on pouvait attendre tranquillement quelques millisecondes qu’il passe un neutron, mais il parut beaucoup plus efficace de provoquer l’allumage de la bombe par une bouffée de neutrons produits par la méthode classique du bombardement de béryllium par des alphas venant d’une source radioactive comme le radium ou le polonium, source radioactive et béryllium n’étant évidemment mis en contact qu’après le rassemblement de la masse critique.

Pour réunir cette masse, le plus fiable d’un point de vue balistique parut d’envoyer l’une contre l’autre dans un canon deux masses chacune légèrement sous-critiques. Pour éviter une détonation prématurée, il fallait réunir les deux masses à 1000 m/s. L’Armée allait juste de mettre en service un canon de calibre 155 mm, le M1 « Long Tom », dont le fût mesurait 7 m de long (6 initialement) et envoyait un obus de 43 kg à la vitesse de 850 m/s. Le tube seul avait une masse de 1240 kg (4300 kg avec la culasse et l’ensemble atteignait 13 tonnes avec l’affût). Une version réduite, de calibre 114 mm, envoyait un obus de 25 kg à 700 m/s, avec un tube de 4.92 m de long et une masse totale de trois tonnes.

Dans le Los Alamos Primer, Serber semble mélanger les nombres car il parle d’un canon de calibre 120 mm, pesant 5 tonnes, mesurant 7 m de long et envoyant à 970 m/s un obus de 25 kg.

Schéma de la configuration « canon » avec tamper (R. Serber, Los Alamos Primer 1943)

La vitesse d’un projectile d’artillerie augmente avec la longueur du fût du canon, car plus celui-ci est long et plus les gaz ont le temps de se détendre et d’accélérer le projectile jusqu’à la sortie, où la pression propulsive disparaît brutalement. Un long canon permet également une accélération plus progressive, une épaisseur plus faible du tube soumis à des efforts moins violents, et un meilleur rendement de la déflagration d’un explosif lent (comme la cordite).

Règle empirique V2 ∝ [1 – E-1/4] où E est le rapport entre le volume du tube et le volume de l’obus (rapport d’expansion). Les spécialistes de l’artillerie affirmèrent qu’il serait possible de réaliser un canon de 6 m de long, tirant un projectile de 25 kg à 900 m/s. Comme le canon serait à usage unique (ou presque, un ou deux essais pouvaient être envisagés), il pourrait être plus mince que la normale et sa masse pourrait ne pas dépasser 2 ou 3 tonnes (OK: longueur 6m, calibre 160mm, épaisseur 60mm, densité 7.9, masse 2000 kg).

La bombe elle-même serait plus lourde, à cause du poids de l’obus, de l’explosif propulseur et de la cible, et des dispositifs de contrôle. Elle serait aussi plus encombrante à cause de l’habillage aérodynamique et des gouvernes. On pouvait donc tabler sur une bombe de 4 ou 5 tonnes et d’environ 10 m de long pour 50 cm de diamètre. Elle aurait eu l’allure d’une très grosse torpille : la remarquable torpille japonaise Type 93 (Long Lance) embarquée sur les croiseurs et destroyers mesurait 9 m de long, 61 cm de diamètre et pesait 2.8 tonnes (dont 490 kg d’explosif), mais elle demeura quasi inconnue des Américains jusqu’à l’obtention d’un exemplaire à peu près intact en 1943.

La bombe envisagée aurait été beaucoup plus lourde et encombrante que celles alors en usage, mais pas hors de portée des bombardiers lourds contemporains. Le Boeing B-17 emportait de 1 à 4 tonnes de bombes selon la distance (700 à 2000 km), de même que le Convair B-24 (plus rapide et avec une autonomie un peu plus grande). Par contre leur soute à bombes (coupée longitudinalement par le "catwalk" connectant l’arrière et l’avant de l’avion) ne permettait pas l’emport de grosses bombes, ni en longueur ni en diamètre. Le B-24 avait deux soutes séparées, chacune de la taille de celle du B-17, mais une charge utile comparable. L’Avro Lancaster et le Handley-Page Halifax emportaient régulièrement jusqu’à 6 tonnes de bombes, et ils avaient de longues soutes (6.7 m de long pour le Halifax, 10 m dans le cas du Lancaster). Le B-29 avait une autonomie et une capacité d’emport très supérieures, mais son prototype ne vola que le 21 septembre 1942, et sa première mission de guerre n’eut lieu que le 5 juin 1944 (à partir de l’Inde contre Bangkok). C’est cependant lui qui fut sélectionné en 1943.

La possibilité d’utiliser deux canons tirant l’un vers l’autre à 500 m/s fut examinée, malgré la difficulté de les synchroniser précisément, car cela aurait fortement allégé la masse totale de la bombe, car la masse d’un canon varie à peu près comme le cube de la vitesse de l’obus. Selon les artilleurs, la mise à feu des deux canons ne pouvait se faire à moins de 500 µs d’écart, déterminant le point d’impact des deux projectiles à 50 cm près (1000 m/s*500 µs). Cela obligeait à entourer le canon d’un manchon de tamper sur toute la zone possible de contact des deux projectiles. Mais si l’on voulait disposer de 4 masses critiques (tamper présent) après la réunion, chacune devrait avoir 2 masses (toujours tamper présent, mais nécessairement moins de 1 masse tamper absent !) et la bombe risquait d’exploser dès que la première pénétrerait dans le manchon, avant la réunion avec la seconde. Cette configuration n’était viable que s’il était possible d’améliorer la synchronisation de la mise à feu d’un facteur 10 au moins (en 1945, les explosifs de Fat Man furent synchronisés à ±10 ns).

La configuration canon possède une grave limitation : il est difficile de rassembler ainsi beaucoup plus de 2 à 3 masses critiques (même en tenant compte du passage d’un cylindre creux à un cylindre plein), ce qui conduit à un rendement plus faible que si l’on peut rassembler 3 ou 4 masses critiques. D’autres formes de projectile et de cible furent donc explorées : cela augmentait fortement la difficulté balistique, mais permettait d’augmenter le nombre final de masses critiques réunies. Inversement, l’idée fut suggérée de placer un bloc de matériau absorbant les neutrons au sein du matériau fissile, et d’expulser ce bloc au moment voulu pour laisser la réaction en chaîne se développer. L’inconvénient était que la disparition de ce bloc laisserait un vide, donc une configuration peu favorable.

Un autre schéma pour réunir plusieurs masses critiques : quatre quarts de sphère disposés en anneau et réunis au centre par une explosion (R. Serber, Los Alamos Primer 1943) Le plutonium ayant une sensibilité plus grande aux neutrons parasites, l’assemblage devrait être plus rapide. Il faudrait donc pour lui un canon plus long, et donc une bombe plus lourde et plus encombrante, mais cela ne sembla pas infaisable.

Implosion ?

Controverse :

- Serber dit que Tolman lui en a parlé au printemps 1942 et qu’il a rédigé une note avec lui, mais aucune trace de cette note n’a été retrouvée ;

- Bethe, Konopinski, McMillan n’ont aucun souvenir que la question ait été abordée lors du Summer Study ;

- Oppenheimer quant à lui attribue (en 1945) l’idée à Neddermeyer qui l’aurait suggéré pendant les réunions de mise en route de Los Alamos en avril 1943 ;

- Kistiakowsky dit que Neddermeyer a eu l’idée via les présentations de Serber (le Los Alamos Primer ne parle pas explicitement d’implosion sphérique, mais Neddermeyer a pu passer de l’idée de réunir 4 quarts de sphères à celle d’implosion ;

- Tolman continua à réfléchir à l’implosion (il explique dans une lettre du 27 mars 1943 à Oppenheimer l’intérêt d’augmenter la densité du cœur par une explosion sphérique convergente). Le terme « implosion » n’est apparemment pas encore utilisé à l’époque

Étant donnée la prévisible difficulté à isoler une quantité importante d’uranium, ou de plutonium, Tolman et Serber suggérèrent d’examiner aussi une configuration « implosion » qui présentait, sur le papier, trois avantages :

- un meilleur rendement

- une masse critique plus faible

- un assemblage plus rapide

Si on y arrivait, l’implosion aurait en effet un bien meilleur rendement, de l’ordre de 10% car le mouvement des masses vers l’intérieur ralentirait l’arrêt de la réaction en chaîne entraîné par la dilatation de la bombe. Ensuite, en augmentant la densité du cœur réactif, l’implosion diminuerait fortement la masse critique nécessaire (qui varie comme l’inverse du carré de la densité). La même quantité d’uranium ou de plutonium pourrait alors servir à plusieurs bombes. Enfin, la possibilité d’utiliser un explosif brisant (ou de haute énergie comme le TNT : détonation supersonique 3 000 à 9 000 m/s) permettant d’atteindre des pressions et des vitesses très supérieures à ce qu’un canon peut tolérer avec un explosif déflagrant (cordite : déflagration subsonique 300 à 1 000 m/s) réduirait la durée de l’assemblage de la milliseconde à la microseconde, éliminant pratiquement le risque de prédétonation. Mais l’implosion serait bien plus délicate à réaliser car une explosion un tant soit peu asymétrique conduirait à un cœur déformé sous-critique. Cette voie ne fut donc pas explorée en détail au cours du Summer Study.

Richard Tolman avec Albert Einstein à Caltech en 1932

Richard Chace Tolman (1881-1948) suivit des études d’ingénierie chimique au MIT, où il passa son doctorat en 1910. Il rejoignit Caltech en 1922 comme professeur de chimie-physique et de physique mathématique. Un des maîtres de la mécanique statistique classique et quantique, il rédigea deux traités sur le sujet, un premier en 1927 (appliquant la théorie de Bohr) et un second en 1938 (appliquant la nouvelle théorie quantique) longtemps resté la référence sur la question. Il s’est beaucoup intéressé aux applications de la thermodynamique à la relativité, depuis les étoiles à neutrons (limite de Tolman-Oppenheimer-Volkoff en 1939) jusqu’à la cosmologie et aux trous noirs. Vice-président du NDRC, il fut l’un des superviseurs du programme Manhattan.

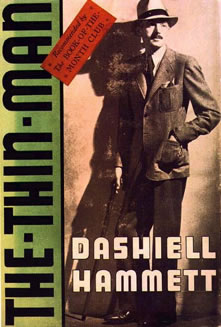

En raison de leurs formes, Serber baptisa Thin Man (l’homme mince) la bombe étroite et longue contenant un canon, et Fat Man (le gros homme) la bombe ronde contenant une sphère explosive. Les noms se référaient à des personnages de films noirs de l’époque (le Thin Man est un personnage, d’après Dashiell Hammett, de la série policière des aventures de Nick et Nora Charles, joués par William Powell et Myrna Loy, et Fat Man est le personnage, toujours d’après Dashiell Hammett et joué par Sydney Greenstreet, qui veut récupérer le faucon dans le Faucon Maltais). Dates ?

The Thin Man d’après Dashiell Hammett

Sydney Greenstreet dans le rôle de Kasper Gutman (The Fat Man) dans Le faucon maltais (1941)

Autocatalyse ?

Teller suggéra une configuration « autocatalytique » de la bombe : l’idée était de placer au centre de la bombe (ou dans plusieurs « bulles ») un matériau absorbant très fortement les neutrons, comme le bore 10 qui a la plus grande section efficace de capture de neutrons rapides. Cela permettrait d’utiliser une masse d’uranium (ou de plutonium) plus importante sans qu’elle soit critique. Lors de l’explosion, le bore ionisé serait beaucoup plus fortement comprimé que l’uranium, l’absorption de neutrons serait fortement réduite et la bombe passerait nettement au-dessus du seuil critique.

Configuration autocatalytique de Teller (Los Alamos Primer)

Teller estimait que l’énergie libérée serait bien plus grande que pour les autres configurations de bombe. Mais l’avis général fut que l’efficacité de cette configuration était plus médiocre encore que les autres (estimation du Los Alamos Primer). En 1944, von Neumann reprit l’idée mais en plaçant un mélange deutérium tritium au centre, en estimant que la fission chaufferait ce mélange et provoquerait des fusions D+T?4He+n (+ 17.6 MeV), et que les neutrons ainsi libérés augmenteraient à leur tour le nombre de fissions et ainsi l’efficacité de la bombe (ceci conduisit aux bombes « boostées » d’après-guerre, testées en 1951 à Eniwetok).

Et la fusion ?

Hans Bethe en 1950 © Life

Bethe, l’auteur de la « bible » de la physique nucléaire en 1936-1937, s’était jusque là tenu à l’écart des projets de réacteur, et plus encore de bombe, car il en jugeait les perspectives très lointaines. En 1940, après la chute de la France, Bethe voulut contribuer à l'effort de guerre contre le nazisme. Sur les conseils de l’aérodynamicien Tódor von Kármán, alors à Caltech, il travailla avec Teller à étendre et raffiner la théorie des ondes de choc et de la turbulence derrière un projectile. Mais il n’obtint la nationalité américaine qu’en mars 1941. Il ne put travailler sur des programmes militaires qu’en décembre 1941 et rejoignit alors le Rad Lab (celui du MIT) pendant un an pour travailler sur le radar, comme beaucoup de ses collègues. Par l’intermédiaire de Van Vleck, Oppenheimer lui demanda de participer au Summer Study de Berkeley. Début juillet, Bethe fit un crochet par Chicago pour prendre Teller en passant, ce qui lui permit de voir l’état d’avancement de la pile de Fermi. Cela le convainquit que la route du plutonium était probablement praticable et conduirait à une bombe en évitant les problèmes épineux de la séparation isotopique.

La ligne du « City of San Francisco » reliant à l’époque Chicago à Oakland en 40 heures

Au cours du long trajet en train vers Berkeley, Teller lui parla des calculs qu’il faisait avec Konopinski à Chicago sur la possibilité d’allumer des réactions de fusion dans le deutérium grâce à la chaleur d’une bombe à fission. À Columbia en septembre 1941, Fermi avait demandé à Teller « out of the blue » si la chaleur (=le flux de rayons X ? Mais d’autres sources comme Goncharov parlent de flux de neutrons) d’une fission pourrait allumer une réaction de fusion dans le deutérium. Après une étude rapide, Teller avait conclu que c’était impossible, mais depuis il avait réexaminé la question et il était maintenant beaucoup plus optimiste. Juste après son arrivée début 1942 à Chicago pour travailler sur les réacteurs, il n’était pas très occupé et il avait repris l’idée de Fermi avec Konopinski, et ils avaient conclu que les obstacles à l’allumage du deutérium n’étaient pas insurmontables.

Edward Teller (1908-2003) © Getty

Mais la fusion de noyaux légers n’est possible qu’à très haute température car les noyaux se repoussent électriquement : il faut donc qu’ils aient une très grande vitesse (soit en les accélérant soit en les chauffant) pour qu’ils puissent approcher assez près les uns des autres pour franchir la barrière électrostatique et fusionner. La barrière se franchissant par effet tunnel, la section efficace augmente exponentiellement (jusqu’à un certain point) avec l’énergie, donc la température. Il s’agit donc de réactions thermonucléaires.

Les énergies minimales étant de quelques dizaines de keV, les températures se chiffrent en centaines millions de degrés (10 keV = 116 MK), et seule une fission parut capable d’allumer une fusion. La « Super », comme on l’appela immédiatement, ne pouvait être qu’une seconde génération d’armes. Son étude ne paraissait donc pas très urgente, mais le problème scientifique était passionnant. Au point que dès le deuxième jour du Summer Study il occupa l’essentiel des discussions puisque Serber, Frankel et Nelson avaient apparemment résolu – en théorie – la question de la bombe à fission. L’intérêt de la fusion, selon Teller, était double :

- le deutérium était beaucoup plus facile, et moins coûteux, à obtenir en grande quantité ;

- il n’y avait pas de limite à l’énergie libérée par une bombe à fusion puisqu’il n’y a pas la limite de la masse critique.

Bethe démolit l’idée de fusion par deux arguments :

- les fusions D-D seraient trop lentes en dessous de 400 MK pour fournir assez d’énergie avant que la fission n’ait détruit tout l’ensemble ;

- et de toute façon, la perte d’énergie par diffusion Compton inverse, dans laquelle les photons de la fission refroidissent les électrons, augmenterait plus vite que la génération d’énergie par fusion.

La discussion se poursuivit le soir dans la maison que Bethe, Teller et Konopinski partageaient à Berkeley pour la durée de la réunion. Konopinski remarqua qu’ajouter du tritium au deutérium aurait le double intérêt de réduire la température nécessaire à l’allumage de la fusion, et de tripler la production d’énergie. La fusion deutérium-tritium libère 330 TJ/kg, à comparer avec les 88 TJ/kg de la fission de l’uranium 235 (et les 4.6 MJ/kg du TNT) et sa section efficace est bien plus grande que celle de la fusion deutérium-deutérium (ou, plus utile pour un concepteur de bombe, la même section efficace est obtenue à température dix fois plus basse). Plus précisément, la production d’énergie par fusion dépasse la perte d’énergie par rayonnement (bremsstrahlung des électrons) au-delà d’un seuil de 400 MK (35 keV) pour la réaction D-D et de 46 MK (4 keV) pour la réaction D-T. La réaction D-T est de loin la réaction de fusion la plus facile car elle met en jeu les noyaux de charge la plus faible (+1) et de taille relativement la plus grande (les neutrons sont peu liés).

Comparaison des fusions D-D et D-T

Mais le tritium n’existe pas naturellement sur Terre car il est fortement radioactif (demi-vie de 12 ans). Il faudrait donc en fabriquer. L’une des possibilités était de bombarder avec des neutrons du lithium 6, produisant ainsi du tritium et de l’hélium 4. Complication supplémentaire, le lithium 6 est un isotope relativement rare qu’il faudrait séparer du lithium 7 bien plus abondant (92.5%). Bien plus tard fut imaginée l’idée de produire le tritium directement pendant l’explosion en mettant dans la bombe de l’hydrure de lithium. Le 1° mars 1954, lors de l’essai Castle Bravo à Bikini, le lithium 7 présent produisit aussi du tritium, par une réaction endothermique alors inconnue, et la quantité de tritium plus importante que prévue conduisit à une explosion trois fois plus intense et des retombées radioactives dramatiques sur les atolls habités de Rongelap et Rongerik à une centaine de km et sur un thonier japonais, le Daigo Fukuryu Maru, faisant des dizaines de victimes irradiées.

Bethe avait longuement étudié toute une gamme de réactions de fusion quelques années auparavant, quand il mettait au point la théorie des réactions nucléaires dans les étoiles (qui lui valut le prix Nobel en 1967). Il avait laissé son nom (et celui de Weizsäcker) au cycle CNO (12C→13N→13C→14N→15O→15N→12C) où le carbone catalyse (en quelque sorte) la fusion de 4 noyaux d’hydrogène pour former un noyau d’hélium. C’est la source d’énergie des étoiles massives, mais les étoiles légères (comme le Soleil) fusionnent 4 noyaux d’hydrogène en noyau d’hélium grâce à une chaîne de réactions dite chaîne proton-proton, dont la première étape fusionne deux protons pour en faire un noyau de deutérium (avec l’émission d’un positron, d’un neutrino, et la libération de 0.42 MeV). Ce deutérium peut ensuite capturer un proton pour créer un noyau d’hélium 3, et deux noyaux d’hélium 3 peuvent ensuite fusionner pour former un noyau d’hélium 4 en libérant deux protons. 26.7 MeV sont libérés quand 4 protons forment un noyau d’hélium. Mais le processus est beaucoup trop lent pour avoir une utilité pratique sur Terre, il n’est viable pour les étoiles qu’en raison des masses considérables mises en jeu (la production d’énergie au centre du Soleil n’est que de 276 W/m3).

Par contre, à la différence des étoiles, rien n’obligeait à partir de l’hydrogène (des protons) pour une réaction de fusion terrestre. Les seules contraintes étaient :

- d’utiliser des noyaux légers, pour minimiser la répulsion électrostatique et faciliter le franchissement de la barrière coulombienne par effet tunnel sans exiger des températures inaccessibles ;

- de se limiter aux réactions à deux corps, car aux densités accessibles la rencontre simultanée de trois noyaux serait hautement improbable ;

- d’avoir une section efficace élevée pour que la probabilité de fusion soit importante, et donc le taux de génération d’énergie très grand (à la différence de la chaîne proton-proton) ;

- et bien évidemment de libérer de l’énergie (réaction exothermique) en grande quantité.

Un inventaire des possibilités indiquait que les réactions a priori les plus intéressantes étaient la fusion de deux noyaux de deutérium ou, mieux encore, la fusion d’un noyau de deutérium avec un noyau de tritium.

D + D → T + p + 4.0 MeV

D + D → 3He + n + 3.3 MeV

D + T → 4He + n + 17.6 MeV

Ces perspectives allaient passionner la plupart des physiciens réunis par Oppenheimer. Les réactions de fusion envisagées ne libéraient que quelques MeV, donc beaucoup moins que les quelques 180 MeV d’une fission. Mais les premiers calculs sur une bombe à fission indiquaient qu’il serait difficile de fissionner plus de quelques centaines de grammes d’uranium ou de plutonium avant que tout se disperse, ne fournissant ainsi que l’équivalent de quelques kilotonnes de TNT. Par contre, l’immense intérêt (d’un point de vue militaire, s’entend) de la fusion est qu’il n’existe pas de masse critique et de ce point de vue une fusion ressemble à une combustion chimique. Par conséquent, il n’existe aucune limite à l’énergie d’une bombe à fusion (ce qu’on nommera plus tard une bombe H) qui peut atteindre des dizaines de mégatonnes en fusionnant quelques kilos de deutérium. Et obtenir du deutérium était nettement plus facile qu’obtenir de l’uranium 235 ou du plutonium.

À l’été 1942, les perspectives d’une bombe à fusion paraissaient séduisantes et, tout en imposant un secret encore plus strict que pour la fission, c’est sur elle qu’Oppenheimer mit l’accent quand il rendit compte à Compton du Summer Study. Oppenheimer s’assura également qu’une installation de liquéfaction de l’hydrogène figure parmi les premiers équipements de Los Alamos. Teller continua ses études à son retour à Chicago. Manley y mesura des sections efficaces deutérium-deutérium. Bethe, Oppenheimer et Lawrence demandèrent que l’on mesure avec le cyclotron de Harvard la section efficace de réaction du tritium avec le deutérium. Compton appuya aussi une demande de Bethe de mesures sur le deutérium et le tritium, que L.D.P. King et Raemer Schreiber effectuèrent à Purdue, et que reprirent ensuite Marshall Holloway (futur responsable du programme thermonucléaire de Los Alamos) et Charles Baker.

Mais la fission demeura prioritaire, malgré tous les efforts de Teller. La conception d’une bombe à fusion se révéla bien plus complexe qu’imaginé en 1942 : il ne suffit pas d’entourer de deutérium une bombe à fission pour en faire une bombe à fusion. La difficulté majeure était d’éviter que l’explosion disperse le deutérium et le tritium avant qu’ils aient pu fusionner, et elle ne fut pas résolue avant qu’Ulam et Teller imaginent en 1951 de comprimer le deutérium par les rayons X d’une bombe à fission (Sakharov et Zeldovitch eurent exactement la même idée en 1954).

Teller souleva un autre lièvre. Il s’inquiéta du risque que la chaleur de la fission provoque la fusion des noyaux d’azote ou d’oxygène de l’atmosphère, ou l’hydrogène de l’eau, et qu’elle conduise alors à un embrasement généralisé de l’atmosphère terrestre et des océans. Ses calculs semblaient indiquer un risque réel, et Oppenheimer s'en alarma suffisamment pour aller voir Compton (en vacances près du lac Oswego, dans le Michigan) et lui demander de regarder cela de près. Mais Bethe avait déjà repris la question, et il montra que les calculs de Teller étaient erronés et le risque nul, même avec les hypothèses les plus pessimistes quant aux températures atteintes et aux sections efficaces des réactions imaginables. La répulsion électrique entre les noyaux d’azote rendait invraisemblable leur fusion.

Conclusions du Summer Study

Les experts réunis (les « luminaires » disait Oppenheimer) confirmèrent la possibilité de réaliser une bombe nucléaire, mais ils soulignèrent qu’il demeurait de nombreuses inconnues, comme les valeurs précises des sections efficaces de fission et le nombre de neutrons secondaires.

Trois points pouvaient rendre impossible le projet de bombe :

- le nombre de neutrons secondaires pouvait se révéler nettement plus faible pour une fission rapide que pour une fission lente (seul cas où ce nombre avait été mesuré, à ~2.4neutrons/fission) ;

- ces neutrons pouvaient ne pas être émis immédiatement (i.e. en un temps < 1 ns) après la fission mais quelques µs plus tard, rendant impossible le développement d’une réaction en chaine explosive avant dissociation de la bombe ;

- la fission du plutonium avait été détectée par les fragments de fission, mais il n’était pas certain qu’elle soit accompagnée de neutrons (en nombre suffisant pour une réaction en chaîne, s’entend).

La première expérience menée à Los Alamos fut précisément la recherche des neutrons secondaires du plutonium : leur nombre (~3/fission) fut une bonne surprise, qui justifiait après coup l’investissement de Hanford. La deuxième expérience fut la mesure du décalage temporel entre fission et émission de neutrons, qui se trouva inférieure à la sensibilité de l’appareillage (~10-14 s). La théorie prévoyait que le nombre de neutrons secondaires devait être à peu près le même dans une fission rapide et dans une fission lente, mais ce ne fut pas confirmé expérimentalement avant 1944.

Malgré les incertitudes sur les valeurs des sections efficaces et du nombre de neutrons, à Berkeley les théoriciens revirent à la hausse de près d’un facteur 6 les valeurs des masses critiques, 30 kg pour l’uranium 235, probablement moins pour le plutonium. C’était plutôt une mauvaise nouvelle puisqu’il faudrait isoler beaucoup plus d’uranium ou de plutonium qu’initialement anticipé, et amplifier en conséquence le programme industriel. D’autant plus que les militaires envisageaient alors l’emploi de plusieurs dizaines de bombes nucléaires pour mettre fin à la guerre. Mais les physiciens revirent aussi à la hausse d’un facteur 100 l’énergie libérée par une explosion, la plaçant désormais entre 10 et 100 kT de TNT, selon le rendement.

Les participants du Summer Study relevèrent aussi que les méthodes de calcul de la diffusion de neutrons devraient être fortement améliorées avant d’obtenir des estimations fiables de la masse critique (surtout avec des formes non sphériques) et de l’efficacité de l’explosion. Celle-ci dépendait aussi crucialement de l’hydrodynamique de l’explosion, qui n’était que très grossièrement modélisée.

Parmi les questions restées ouvertes, le choix d’utiliser l’uranium sous forme pure (métallique) ou sous forme d’un composé (l’hydrure fut longuement étudié à Los Alamos), le choix du réflecteur de neutrons (tamper), le choix du mécanisme d’assemblage (un canon, deux canons, implosion ?)

La première page dactylographiée du Los Alamos Primer, longtemps classée Top Secret

Les conclusions du Summer Study Group furent synthétisées dans une série de conférences données par Robert Serber aux nouveaux arrivants à Los Alamos les 5, 7, 9, 12 et 14 avril 1943. Les notes prises par Condon à cette occasion forment le Los Alamos Primer, un remarquable texte de 26 pages denses qui présentent toute la physique nécessaire (théoriquement) pour construire une bombe nucléaire. Mais il manquait encore beaucoup de choses…

Le groupe se sépara fin août, chacun reprenant ses activités dans l’attente de résultats expérimentaux (les mesures de sections efficaces de neutrons en particulier) pour aller plus loin. « Everyone seemed to be saying, well, that's all settled, let's talk about something interesting, » dit Serber. Oppenheimer présenta les conclusions du Summer Study Group à Compton (en mettant l’accent sur la « Super »). Celui-ci les transmit au Comité S-1 et en particulier à Conant et à Bush, qui à son tour les communiqua à Stimson le 29 août. Le 13 septembre, le comité S-1 évalua la création d’un laboratoire centralisant toutes les recherches sur les neutrons rapides, le Projet Y. Du 19 au 23, Fermi, Oppenheimer, Manley et Lawrence discutèrent de ce laboratoire à Chicago, et le 29 septembre, Oppenheimer appuya sa réalisation immédiate. Il fut d’abord envisagé de l’installer à Chicago, puis Groves voulut l’ajouter à Oak Ridge avant de changer d’avis, et de décider le 12 octobre de le séparer des installations existantes ou prévues, et de créer un nouveau site (le site Y qui fut Los Alamos).Mais à ce stade il n’était question que d’un petit laboratoire de recherche sur la physique des neutrons rapides, pas encore d’un établissement concevant et réalisant des armes.

Une des principales difficultés relevées par les théoriciens était le manque de données fiables sur la fission rapide, et un programme intense de mesures fut lancé. Des études expérimentales étaient déjà en cours à l’université du Wisconsin (Joseph McKibben) et à Cornell (Robert Bacher). Bacher en particulier équipait le cyclotron de Cornell d’un « sélecteur de vitesse » pour isoler des neutrons rapides et mesurer ainsi la section efficace de fission de l’uranium 235 à une énergie de l’ordre du MeV. À Berkeley, Segrè utilisa le cyclotron pour photodésintégrer le béryllium ou le deutérium, donnant des neutrons d’énergie modulable entre 0.22 et 0.65 MeV. Il obtint en octobre 1942 une section efficace de fission pour l’uranium 235 de 2.8 barns à 0.22 MeV et de 1.7 barns à 0.43 MeV. Des révisions de la calibration avaient augmenté ces nombres de 40% au dernier moment, et Oppenheimer demeura sceptique sur leur fiabilité. À Carnegie, Norman P. Heydenburg employa le Van de Graaf, capable de produire des neutrons mono-énergétiques dans l’intervalle 0.025-4 MeV (par collisions deutéron-deutéron ou deutéron-carbone). Les résultats de Heydenburg étaient encore plus problématiques, en raison de profondes incertitudes sur la contribution de l’uranium 238 dans les mesures (on se trouve autour du seuil de la réaction de fission de l’uranium 238). Finalement, les neutrons venant de collisions deutéron-deutéron ou deutéron-carbone furent jugés impropres aux mesures de section efficace.

Il était également très important de mesurer le spectre en énergie des neutrons produits par la fission, et plusieurs groupes s’efforcèrent de le faire en examinant le recul des protons avec des chambres d’ionisation, ou des chambres à brouillard. À Berkeley, Felix Bloch utilisa des neutrons produits par le cyclotron, à l’université du Minnesota, John Williams utilisa le Van de Graaf, à Rice H.A. Wilson et William C. Bennett utilisèrent le Van de Graaf pour fabriquer des neutrons par collisions deutéron-deutéron.

Au printemps 1943, Alfred O. Hanson et D.L. Benedict, au Wisconsin, parvinrent à produire des neutrons mono-énergétiques en bombardant du lithium avec les protons du Van de Graaf, et à mesurer séparément les sections efficaces de fission de l’uranium 235 et de l’uranium 238 en fonction de l’énergie (ils précisèrent en particulier le seuil de la fission pour le 238).

Les sections efficaces de fission du plutonium 239 et de l’uranium 235 et 238 connues en avril 1943 (Los Alamos Primer)

La mesure des sections efficaces du plutonium se révéla encore plus difficile. Les propriétés physiques et chimiques en étaient alors inconnues, la forte radioactivité alpha compliquait la tâche (l’accumulation des alphas formaient un important bruit de fond pour la détection des fissions). La demi-vie du plutonium 239 était encore mal connue, rendant difficile l’estimation de la quantité de plutonium (mesurée par son activité) présente dans l’échantillon. Et cette quantité intervient dans le calcul de la section efficace : même la section efficace de fission par neutrons lents, beaucoup plus grande que par neutrons rapides, n’était connue qu’à un facteur 2 près. Heydenburg mesura pendant l’hiver 1942-1943 le rapport des sections efficaces de fission du plutonium et de l’uranium de 1 eV à 3.95 MeV.

Chronologie