Alain Bouquet - L'Atomisme moderne

Attention: ces pages ne sont plus mises à jour car le site a déménagé. Il se trouve désormais à: Pensez à mettre à jour vos signets et bookmarks! |

Champs, Noyaux & particules

Radioactivité

Noyaux, protons et neutrons

- Noyau atomique: Rutherford

- Noyau atomique: Bohr, Soddy et Moseley

- Noyau atomique: Aston et Rutherford

- Neutron: Chadwick

- Neutron: Joliot-Curie

- Neutron: Fermi

Intruments, accélérateurs et détecteurs

Mécanique quantique

- Mécanique ondulatoire

- Formalisme quantique

- Applications

- Théorie quantique des champs

- Électrodynamique quantique

Fission nucléaire

Fusion nucléaire

Particules en tout genre

Dalton et l'atomisme moderne

Le retour de l'atomisme

Transition plus ou moins progressive de la physique du continu (Descartes) à la physique des corpuscules (Newton).

Les tourbillons de Descartes

Il n'y avait toujours aucun argument expériemental en faveur des atomes, mais la notion parut progressivement plus simple à mettre en oeuvre (i.e. désormais en équations) que l'idée de matière continue. À la différence de l'atomisme antique, la notion ne s'appliquait qu'au monde matériel et les atomes n'avaient pas d'autres attributs, initialement, que leur masse, leur mouvement, et peut-être leur taille et leur forme. Toutes les propriétés macroscopiques (couleur, goût, élasticité…) étaient des propriétés résultant de leur assemblage (propriétés émergentes dans le vocabulaire contemporain). Ceci était complètement à l'opposé des notions aristotéliciennes de substance et de forme, et ave cles "principes" des alchimistes (mercure, or…)

Minima naturalia

La physique d'Aristote classait le changement en trois catégories:

- le mouvement, où forme et substance sont conservées

- la génération et la corruption, où la substance est conservée mais change de forme

- le mélange, où forme et substance sont modifiées (les alliages par exemple de cuivre et d'étain)

Mais, dans le cas d'un mélange, qu'advenait-il des composantes qui disparaissaient au regard mais retaient présentes puisqu'on pouvait - parfois - les séparer à nouveau? D'où l'idée des minima naturalia, des versions miniatures de la matière (avec les mêmes propriétés, donc des propriétés non-émergentes). Autre différence avec les atomes: les minima du cuivre et les minima de l'étain devenaient des minima du bronze. Analogie fréquente avec les notes d'un accord.

Qu'apportait l'idée des minima naturalia? ➛ voir pourquoi Aristote les a introduit.

Newton

- espace et temps continus (pour des raisons à l'origine théologiques, via la mystique juive et la théologie de la lumière)

- mais atomes (ponctuels, ou du moins impénétrables) soumis aux 3 lois du mouvement (➛ soumis à des forces)

- atome ➛ masse (corps dense ⇔ faible distance interatomique ?)

- force ➛ propriété de l’atome ? Des paires d’atomes ?

Grands efforts pour expliquer en termes d’atomes et de forces

- la gravitation

- la lumière (corpusculaire!): réflexion, réfraction, diffraction et interférences (anneaux de Newton)

- la cohésion des matériaux

- leur élasticité

- les frottements

- la pression

- la chaleur …

➛ des forces partout !

- tensions de surface

- frottements

- forces électriques attractives, répulsives

- forces magnétiques

➛ propriétés nouvelles des atomes, comme la charge électrique. Mais la chimie du 18° siècle, elle, n’utilise pas les atomes, elle est continuiste! Au 19° sicèle, c'est d'ailleurs l'inverse, les chimistes utilisent plutôt les atomes et les physiciens plutôt le continu…

Infinitésimaux

Atomes et forces → Newton a une approche cinématique de la géométrie et des fonctions: l'abcisse est implicitement le temps, l'ordonnée d'une courbe est la position d'un mobile, la tangente de la courbe en un point est la vitesse instantanée de ce mobile, et l'intégrale de la courbe est le chemin parcouru → méthode des fluxions.

- quantité engendrée par un mouvement → fluent

- taux de variation du fluent → fluxion

- fluxion → fluent : intégrale (quadrature)

- fluent → fluxion : dérivée (tangente)

Leibniz (1646-1716)

Arrive au calcul infinitésimal par une autre voie: arguant que tout ce qui réel est formé d'éléments irréductibles, les monades, il se heurte à la difficulté de construire le continu à partir d’indivisibles. D'où introduction des infinitésimaux (introduisant la notation dx encore utilisée) et de règles de calcul pour les manipuler (avant de le snégliger à la fin). Leibniz donne des règles pour calculer la quantité infinitésimale dy en fonction de dx pour une fonction y=f(x). Pour lui, d est un opérateur appliqué à une variable ou une fonction, et son action peut donc être répétée: d(df)=d2f → calcul intégral et différentiel

Leibniz acceptait-il l'atomisme? Natura non fecit saltus…

Berkeley (1685-1753)

Sa philosophie (Esse est percipi) le conduisit à rejeter l'idée que l'esprit crée des objets mathématiques par abstraction (comme le disait Aristote) et à affirmer au contraire que le smathématiques ne concernaient que les objets sensibles. Les infinitésimaux était donc pour lui de pures fictions dont on devait se passer, aussi pratiques fussent-ils.

Euler (1707-1783)

Euler pensait l'univers empli d'un fluide éthéré et continu et considérait la lumière comme une onde. Son analyse des phénomènes physiques, des fluides en particulier, le conduisit à l'approche dite eulérienne où un élément du fluide est considéré comme déformable mais de volume constant. Appliquée au calcul différentiel, son approche considérait les infinitésimaux comme nuls (dx=0, dy=0 mais dy/dx=0/0 peut prendre une valeur définie → règles de calcul)

Vocabulaire non fixé: différentielles = infinitésimaux = quantités évanescentes

Kant (1724-1804)

La réaité se divise en deux domaines

- les phénomènes, sujets de l'expérience sensible et donc configués par les formes de la sensibilité

- les noumènes, entités auquel aucun objet d'expérience ne peut jamais correspondre

Les objets de l'expérience sensible sont étendus dans l'espace et dans le temps, et ils sont continus (apparemment divisibles à l'infini). Pourtant ils se présentent à nous de façon intensive (luminosité, température…) et non extensive. La seconde des antinomies de Kant porte justement sur la caractère intrinsèquement discret ou continu de la matière, et il démontre simultanément les deux thèses → la matière comme l'extension ne sont qu'apparences et ne nous informent pas sur la chose-en-soi.

Connexion algèbre (=discontinu) ⇔ géométrie (=continu) ☞ résolution au 19° siècle des paradoxes liés à l’infini avec les travaux de Cauchy, Bolzano, Weierstrass, Dedekind et Cantor → ℵ0

Proust et la loi des proportions définies

Joseph Louis Proust (1754-1826)

Loi des proportions définies (1794)

- dans tout corps composé, les proportions en masse des constituants sont identiques quelle que soit la façon de l’obtenir

- vert-de-gris ou carbonate de cuivre de synthèse → mêmes proportions de cuivre, carbone et oxygène

- ➛ controverse avec Berthollet

La chimie n’est pas de la cuisine ! On peut mettre plus ou moins de farine, plus ou moins de lait (ou le remplacer par l'eau) ou de sucre, on obtient toujours une tarte, plus ou moins bonne. On n'obtient pas une tarte accompagnée de la farine ou de l'oeuf en excès. Mais si l'on fait réagir de l'hydrogène et de l'oxygène en quantités quelconques, on obtient de l'eau accompagnée d'un excès d'hydrogène ou d'un excès d'oxygène, pas des qualités d'eau différentes.

John Dalton (1766-1844)

Dalton explique en 1803 la loi des proportions définies de Proust en supposant la matière formée d’atomes minuscules et inaltérables. Son apport crucial est d'avoir proposé qu'à chaque élément chimique différent correspondait un type différent d'atomes (ceci était un recul par rapport à l'idée de constituant universel). Mais tous les atomes d'un même élément (carbone, oxygène…) étaient identiques. Ces atomes s’assemblaient toujours dans les mêmes proportions (1 atome de carbone avec 1 ou 2 atomes d’oxygène, jamais 3 ou 4, ni bien évidemment 0.5 ou 1.3 !). Et, en s'appuyant sur Lavoisier et Proust, Dalton pouvait calculer pour la première fois les masses (relatives) des atomes.

Dans sa publication majeure de 1808, Dalton établit une liste initiale d'atomes (H, C, N, O, P, S) élargie ensuite, ainsi qu'une liste de leurs composés. Il estime la masse de l’atome d’azote à 5 fois celle de l'atome d’hydrogène [14], celle de l’atome d’oxygène à 7 [16]. Son erreur (en dehors de l'imprcsision des mesures de masse à cette époque) est d'avoir par exemple attribué à l'eau la formule HO au lieu de H2O et la formule NH à l'ammoniac au lieu de NH3.

Dalton a également suggéré (1808) des symboles pour les atomes, mais sans succès :

Dalton établit également la Loi des proportions multiples: si deux corps peuvent former plusieurs composés, les rapports de masse entre les composantes sont toujours des rapports de nombres entiers.

Par exemple les oxydes d’azote sont NO, N2O, NO2, N2O3 et N2O5. Ceci est automatiquement expliqué par la théorie atomique: les atomes qui s'associent sont nécessairement en nombre entier!

Par contre, Dalton ne pouvait pas expliquer pourquoi certains atomes s'associaient entre eux et pas d'autres.

Lois de Charles et de Gay-Lussac et hypothèse d'Avogadro

Lois de Charles et de Gay-Lussac: pression*volume/température = constante (loi des gaz parfaits)

Gay-Lussac montra en 1808 que les rapports entre les volumes de gaz qui entrent en réaction sont toujours des rapports de nombres entiers, et des rapports constants: 1 volume d'oxygène se combine à deux volumes d'azote pour donner deux volumes de vapeur d'eau (à température et pression constantes bien sûr).

Amedeo Avogadro suggéra en 1811 que cela s’expliquait simplement si un volume donné de gaz contenait toujours le même nombre de constituants élémentaires, quel que soit le gaz. Mais cela impliquait qu'un "atome" d'eau ne contenait qu'un demi "atome" d'oxygène pour un "atome" d'hydrogène. Autrement dit, Avogadro concluait que les constituants de l'hydrogène gazeux n'étaient pas les atomes de Dalton, mais des molécules formées chacune de deux atomes (H2), et qu'il en était de même pour l'oxygène (O2). Alors l'eau devait être H20 …

L'hypothèse d'Avogadro trouve son explication dans la théorie cinétique des gaz, où la loi des gaz parfaits s'écrit PV=NkT, où N est le nombre d’Avogadro: 1g d’hydrogène = 6,02*1023 atomes. Dans la théorie cinétique des gaz, la pression P est proportionnelle à l'énergie cinétique totale des particules, donc au nombre N de ces particules multiplié par l'énergie cinétique moyenne de ces particules, elle-même proportionnelle à la température T (E=3kT/2 pour des molécules monoatomiques, 5kT/2 pour des molécules diatomiques).

Mais même sans explication de son origine, l'ypothèse d'Avogadro était fructueuse car les formules chimiques ainsi obtenues

- étaient cohérentes d'une réaction à l'autre, et

- donnaient toujours la même masse atomique pour un élément chimique donné (en unités de l'une d'entre elles, généralement l'hydrogène) dans toutes les réactions où intervenanit cet élément

Par exemple, un volume d'azote se combine à 3 volumes d'hydrogène pour former 2 volumes d'ammoniac ➛ la formule chimique d el'ammoniac est NH3 et la réaction s'écrit

N2 + 3 H2 ➛ 2 NH3

En masse, 14 g d'azote se combinent à 3 g d'hydrogène pour former 14+3=17 g (conservation de la masse!) d'ammoniac ➛ la masse de la molécule d'azote est 14 fois plus grande que celle de la molécule d'hydrogène, et comme ces molécules sont toutes deux diaomiques, la masse de l'atome d'azote est également 14 fois celle de l'atome d'hydrogène.

Berzélius

Jöns Jacob Berzelius (1779-1848) suivit l'idée d'Avogadro et publia des tables de rapports de masse (en 1814, 1818 puis 1828) pour un nombre croissant d'éléments. Il découvrit également, seul ou avec ses élèves, plusieurs nouveaux éléments (Ce, Se, Th, Li, V, Si, Zr, Ti). il se fit aussi connaître par d'importants travaux sur le fluor, le soufre, le phosphore… ainsi qu'en chimie organique (il inventa le terme de protéine en particulier) et la catalyse.

Table de poids équivalents (selon le dictionnaire Larousse de 1868)

C'est Berzélius qui introduisit la notation moderne pour les atomes (une lettre – ou deux lettres –suivie d'un chiffre indiquant le nombre d'atomes dans une molécule) et la notion de formule chimique (mais les ambiguïtés entre AB, AB2, A2B, A3B4, etc. furent longues à réduire). Peu à peu se fit la distinction entre chimie minérale (arrangements simples, souvent répétés, d'un grand nombre d'éléments chimiques différents) et la chimie organique (arrangements complexes d'un petit nombre d'éléments différents, essentiellement C, H, O et N). Mais la complexité de ces arrangements rendit vite les "formules brutes" insuffisantes. Par exemple, le vinaigre (acide acétique) vit d'abord sa formule passer de CH20 à C2H4O2 pour expliquer pourquoi l'on obtenait pas moins de quatre corps différents par remplacement d'atomes d'hydrogène par des atomes de chlore, puis à CH3-COOH pour expliquer pourquoi trois de ces corps étient des acides (remplacement de 1, 2 ou 3 des atomes H de la première moitié) et le quatrième un sel (remplacement de l'atome H de la seconde moitié).

acide acétique

acide acétique

Berzélius est ainsi à l'origine de la notion d'allotropie (graphite ≠ diamant, O2 ≠ O3) et de celle d'isomérie (C2H6O : éthanol CH3-CH2-OH ou méthoxyméthane CH3-O-CH3) aux propriétés physiques (point d'ébullition par exemple) et chimiques très différentes bien que formés des mêmes atomes. On découvrit ensuite l'existence des stéréo-isomères (comme les énantiomères de l'acide tartrique dont Pasteur étudia les propriétés opposées de polarisation de la lumière, dues à leurs structures moléculaires inversées en miroir).

Berzélius eut moins de succès avec sa théorie du dualisme électrochimique (1819) selon laquelle toute molécule est l’union de 2 parties (radicaux), une électropositive et une électronégative. Berzélius tentait ainsi d'expliquer pourquoi certaines réactions chimiques avaient lieu et d'autres non. Que les forces associant les atomes en molécules soient d'origine électrique paraissant évident aux chimistes depuis la découverte de l'électrolyse des corps composés et Berzélius établit une échelle allant de l’oxygène (l'élément le plus électronégatif selon lui) à l’hydrogène (le plus électropositif). Il classait ainsi l'oxyde de cuivre CuO comme légèrement électropositif et l'anhydride sulfurique (ou trioxyde de soufre) SO3 comme légèrement électronégatif. Ils avaient donc tendance à s'associer pour former du sulfate de cuivre CuSO4. Mais cela n'expliquait pas l'existence des molécules d’hydrogène, de chlore ou d’oxygène formées de deux atomes identiques.

Faraday et l'électrochimie

Électricité

L’ambre (ἤλεκτρον) frotté avec une fourrure attire de petits objets. le même effet peut s'obtenir avec une baguette en verre, un morceau de soufre ou de cire, ou de la résine

Mais était-ce dû au frottement lui-même ou bien à la chaleur dégagée par ce frottement?

un fluide (effluvium) émanant du corps mais indépendant de lui (Gilbert 1600)

découverte de la conduction (Gray 1729)

deux types d’électricité (du Fay 1733): vitreuse et résineuse

Question ouverte (→ fin 19° siècle): S'agissait-il de deux fluides différents (Nollet 1743) ? ou un seul (Franklin 1758) ? Franklin identifia électricité vitreuse = excédent (électricité positive) électricité résineuse = déficit (électricité négative)

En fait les deux idées sont justes il existe des charges positives (protons) et des charges négatives (électrons)

Découverte progressive des forces entre corps électriquement chargés

- Robinson (1769) : répulsion en 1/r2

- Cavendish (1775) : attraction en 1/r2

- Coulomb (1785) : force en 1/r2 et proportionnelle aux charges q1 et q2

F = q1 q2/r2

Similarité avec la loi de la gravitation de Newton

Faraday

Une charge q1 crée à distance r un champ électrique E = q1/r2

Une charge q2 placée dans un champ électrique E subit une force F = q2 E

Cela se généralise à des répartitions complexes de charges

Électrolyse

Découverte accidentelle en 1800 par Nicholson & Carlisle qui expérimentaient avec une pile de Volta et placèrent une goutte d'eau aux contacts des fils avec les bornes de la pile pour améliorer la conduction. Ils observèrent avec surprise l'apparition de bulles de gaz à chacun des contacts. Ils montrèrent qu'il s'agissait d'oxygène côté positif et d'hydrogène côté négatif.

☛ ils avaient retrouvé la décomposition de l’eau en hydrogène et oxygène démontrée quelques années plus tôt par Lavoisier, mais cette fois par des méthodes électriques. Il y avait donc un lien insoupçonné entre la chimie et l'électricité.

☛ décomposition d’autres substances (Humphry Davy): l'électrolyse de la soude et de la potasse permit d'isoler le sodium et le potassium (trop réactifs pour exister isolément dans la nature).

Avec des sels fondus ou dissous (du sel de cuisine, ou chlorure de sodium, par exemple), on obtient généralement un métal du côté – (cathode), du sodium dans cet exemple, et un gaz côté + (anode), ici du chlore . Les proportions en masse des éléments obtenus par électrolyse d'un corps étaient toujours les mêmes, et correspondaient à celle des réactions chimiques qui reformaient le corps initial.

Théorie : Faraday (encore)

En 1830, Faraday présenta la première théorie correcte de l'électrolyse, définissant au passage le vocabulaire actuel (ion, électrolyte, électrode, anode, cathode, termes suggérés par Whewell à la demande de Faraday):

- dissociation en ions de charges positives et négatives

- les ions sont attirés par les électrodes de signe opposé, auxquelles ils prennent ou cèdent des charges compensatrices q

- les ions redeviennent ainsi des « atomes » neutres

Les charges compensatrices de Faraday sont en fait les électrons, que la pile met en mouvement d'une électrode à l'autre quand le circuit électrique est refermé. Ce courant électrique est mesurable (par ses effets magnétiques entre autres). Par exemple:

- H2O → H+ + OH– (dans l'eau pure, c'est le cas de deux molécules sur un million)

- H+ + q– → ½ H2

- OH– → ½ H2O + 1/4 O2 + q-

De même le chlorure d'argent AgCl se décompose en ions argent Ag+ et en ions chlore Cl–, l'ion argent est attiré par la cathode où il récupère un électron e– et forme un dépôt d'argent métallique, l'ion chlore est attiré par l'anode où il cède un électron et forme du chlore gazeux.

Faraday effectua des séries de pesées et montra que les éléments libérés par électrolyse sont toujours dans les mêmes proportions en masse. L'eau donne toujours 8 g d'oxygène par gramme d'hydrogène libéré, que ce soit par les méthodes chimiques de Lavoisier ou par électrolyse. Il était ainsi possible de définir une unité de charge électrique par le dépôt d’une quantité donnée d'un élément à une électrode. Pour des raisons pratiques, l’argent fut choisi et le faraday fut défini comme la quantité d'électricité qui déposait une mole (108 g) d'argent à la cathode. La constante de Faraday relie cette quantité à l'unité de charge électrique, le coulomb: 1 F = 96485 C.

Si l'hypothèse atomique était vraie, cette quantité d'électricité devait être égale au produit d'une charge électrique élémentaire par le nombre d'Avogadro. Celui-ci était mal connu, mais après que Loschmidt l'eut estimé en 1865 à 1024, George Johnstone Stoney proposa en 1874 de donner le nom d'électrine à cette charge élémentaire, qui serait donc de l'ordre de 10-19 coulombs. Stoney le changea ce nom en électron en 1891. Ce nom fut ensuite donné à la particule découverte par J.J. THomson en 1897, précisément porteuse de cette charge (dont la valeur est aujourd'hui plus précise: 1.6021766×10−19 C)

Mendeleiev

De plus en plus d'éléments

1800: 30 éléments identifiés

1860: 60 éléments

- ➛ propriétés physiques (masse atomique, densité, états solide, liquide et gazeux selon la température, propriétés élecriques et magnétiques…)

- ➛ propriétés chimiques (affinités d'un élément avec lui-même et avec d'autres éléments, valence…)

En classant les éléments par masse atomique croissante ➛ régularités observées fluor, chlore, brome, iode… ou encore lithium, sodium, potassium… ou encore carbone, silicium…

➛ très nombreux essais de classement

- triades de Döbereiner (1817)

- tétrades de Dumas (1859)

- vis de Chancourtois (1862)

- octaves de Newlands (1863)

- tableau de Mendeleiev (1869)

Mendeleiev

Dmitri Ivanovitch Mendeleïev (1834-1907)

Lui aussi, Mendeleieiv rangeait les éléments rangés par masses croissantes dans un tableau. Mais pour retrouver les mêmes propriétés chimiques dans une rangée donnée (aujourd'hui une colonne, le tableau initial a été tourné de 90°), Mendeleiev eut l'idée géniale de laisser des trous dans son tableau. Il supposa qu'il restait encore des éléments à découvrir, ce qui n'avait rien de choquant puisqu'on découvrait alors un nouvel élément (presque) chaque année.

La première version du tableau de Mendeleiev

Figure de l'article de Mendeleiev plaçant sur la même rangée les éléments de mêmes propriétés chimiques

⇒ mais cela lui permettait de prédire la masse atomique et les propriétés chimiques des éléments inconnus, auxquels il donnait le nom de l'élément chimiquement analogue précédent, précédé du préfixe eka

- éka-bore ➛ scandium (1879)

- éka-aluminium ➛ gallium (1875)

- éka-silicium ➛ germanium (1882)

Mendeleiev avait également dû permuter certains éléments pour que leurs propriétés chimiques corrspondent mieux à leur position dans le tableau, même si cela l'obligeait parfois à ne pas suivre exactement l'ordre des masses atomiques croissantes.

- cobalt (m=58,9) placé avant lenickel (m=58,7)

- tellure (m=127,6) placé avant l'iode (m=126,9)

La découverte de l'hélium (dans le spectre du Soleil avant qu'il soit identifié dans des roches terrestres) puis celle de l'argon en 1894 posa un léger problème car ils n'avaient pas de place dans le tableau de Mendeleiev. Une nouvelle colonne (dans l'orientation actuelle du tableau) fut ajoutée pour la série de gaz inertes, hélium, néon, krypton, xénon puis radon.

Un autre problème se posa après la découverte de la radioactivité, car une quarantaine d'éléments nouveaux (aux propriétés physiques différentes) devaient se placer dans la dizaine de cases entre le plomb et l'uranium. Quand il faut reconnu que plusieurs d'entre eux partageaient les mêmes propriétés chimiques, Frederick Soddy rassembla tous les éléments de mêmes propriétés chimiques dans la même case, même si leurs propriétés physiques (masse et durée de vie pour les élément instables) différaient. Soddy baptisa isotopes (même endroit) ces éléments chimiquement identiques et physiquement différents. Enfin Henry Moseley démontra que les éléments du tableau périodique devaient être rangé par nombre Z croissant d'électrons, indépendamment de leur masse atomique A (bien qu'il y ait une corrélation entre Z et A). Enfin, il apparut que les éléments qui suivaient le lanthane (les "terres rares") avaient des propriétés chimiques bien plus proches qu'on le pensait, ce qui conduisit à les placer tous dans la même case (lanthanides). Et il en fut de même des éléments suivant l'actinium, les actinides.

Constituants ?

La plupart des éléments ont une masse atomique proche d’un multiple entier de celle de l’hydrogène, mais pas tous (chlore m=35.5) ce qui suggéra à plusieurs reprises que l’hydrogène pourrait être LE constituant universel. William Prout (1785-1850) suggéra ainsi en 1815, à partir des premières tables de masses atomiques, que tout était en réalité formé d'atomes d'hydrogène. Il est possible que Rutherford ait en partie baptisé le proton (noyau de l'atome d'hydrogène) en hommage à W. Prout.

Mais alors en quoi un atome de carbone (de masse 12) diffère-t-il d'une molécule qui serait formée de 12 atomes d'hydrogène? Et pourquoi la masse atomique des éléments connus est-elle souvent un nombre pair pour les éléments légers?

Et pourquoi

- des masses atomiques proches ont-elles des propriétés très différentes (aluminium et silicium, par exemple, les éléments n° 13 et 14)

- des masses atomiques très différentes ont-elles au contraire parfois des propriétés voisines (chlore, élément n°17, et iode, élément n°53)

- les éléments de masse 2, de masse 3, de masse 4 (jusqu’à la découverte de l’hélium) n'existent-ils pas?

Stabilité des atomes

Une question connexe portait sur la permanence des atomes dans les réactions chimiques. Aucune réaction chimique ne pouvait crééer un atome ni le détruire. Pourquoi, si un atome était un assemblage de pièces plus petites, un réarrangement ne se produisait jamais?

Certains physiciens, par exemple Crookes en 1886, avancèrent toutefois que les atomes avaient peut-être des masses individuelles variables et que l'on ne mesurait en réalité que la masse moyenne des atomes. le nombre d'atomes étant toujours très élevé, la dispersion statistique était faible, ce qui expliquait pourquoi on trouvait toujours la même valeur aux erreurs de mesure près. Stricto sensu, ce n'est pas faux à cause de l'existence des isotopes: un élément isolé chimiquement est toujours une superposition de différents isotopes, et la composition isotopique varie légèrement de place en place ainsi qu'au fil du temps (➛ cela permet d'ailleurs d'identifier l'origine géographique de certains éléments, ou l'âge d'un échantillon).

Helmholtz 1858: théorie de la stabilité des tourbillons (vortex)

Kelvin 1867: les atomes sont des tourbillons de l’éther (= champ électromagnétique) ?

Ou des nœuds (Kelvin et Tait)

Ce n'est qu'après la mise en place de la mécanique quantique que Heitler et London élaborèrent en 1927 la notion de liaison covalente, permettant de comprendr pourquoi deux atomes d'hydrogène pouvaient former une molécule stable, mais pas quatre atomes.

Atomes et électromagnétisme

Théorie cinétique des gaz

La thermodynamique classique avait conduit à trois "principes" extrêmement bien vérifiés par l'expérience:

- conservation de l’énergie

- impossibilité de conversion totale de la chaleur en travail

- impossibilité de parvenir à T = 0

La théorie cinétique des gaz, développée par Maxwell (1859) puis Boltzmann (1872), repose sur l'idée que les gaz sont formés d'un très grand nombre de particules (atomes, molécules…) de très petite taille, animés d'un mouvement incessant les amenant à entrer en collision de manière (plus ou moins) aléatoire les uns avec les autres, ou avec les parois d'une enceinte.

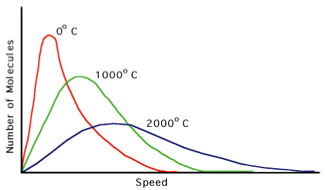

Ces collisions provoquent des échanges d'énergie (cinétique), échanges qui conduisent la distribution de vitesse des particules à tendre toujours vers une forme limite, la distribution de Maxwell-Boltzmann:

N(v) = Ntot 4π [m/2πkT]3/2 v2 exp{–mv2/2kT}

faisant apparaître une variable T (ou plus exactement 3kT/2 qui est l'énergie cinétique moyenne de ces particules Ecin = ½ m <v2>), et que l'on identifie à la température de la thermodynamique classique (chaleur ≣ mouvement désordonné d’un grand nombre de particules). La force moyenne exercée sur les parois de l'enceinte par les chocs multiples des particules est identifiée à la pression macroscopique, et l'on retrouve ainsi la loi des gaz parfaits sous la forme PV=NkT

☞ E en joules, T en kelvins → k = 1,38*10–23 J/K

En 1865, Loschmidt put donner une évaluation du nombre d'Avogadro de l'ordre de 1024, à partir de la comparaison entre théorie cinétique des gaz (faisant intervenir des quantités microscopiques comme la masse et le nombre des atomes) et la thermodynamique classique (faisant intervenir des quantités macroscopiques, pression, volume et température).

La théorie cinétique des gaz prédisait que la viscosité d'un fluide ne devait pas dépendre de sa densité (ce qui était contraire à l'intuition mais fut vérifié), et elle permettait également de calculer - correctement - l'écart à la loi des gaz parfaits quand la densité augmentait et que le libre parcours des particules entre collisions approchait de la taille des particules (→ équation de van der Waals).

Magnétisme

Thalès mentionne l'effet de la « pierre de Magnésie » (la magnétite, un oxyde de fer Fe3O4) sur le fer qui en est extrait: le fer est attiré par elle comme l'enfant par sa mère. Aussi appelée "pierre d'Héraclée" ou "pierre de Lydie", elle est également citée par Platon dans le Timée, et par Aristote (qui cite Thalès).

La boussole est utilisée au 1° siècle en Chine à des fins magiques (feng shui) car elle indique la direction du Sud. Un texte de 1088 signale qu'elle sert à diriger les jonques en haute mer (sous la forme d'un poisson de fer aimanté par refroidissement). Son utilisation en Occident est mentionnée en 1180 dans un texte de Neckam, qui en parle comme d'usage courant chez les marins.

Boussole chinoise d'époque Han (copie moderne) et boussole contemporaine

Pierre de Maricourt (1269) note dans son De magnete que les aimants ont toujours deux pôles, et William Gilbert (De magnete 1600) étudie minutieusement les deux phénomènes électrique et magnétique, et conclut à leur profonde différence car l’ambre attire n’importe quoi, mais après avoir été frottée, alors que la magnétite n’attire que le fer, mais en toutes circonstances. Les deux phénomènes sont ensuite étudiés de façon indépendante, jusqu'à la découverte accidentelle d'un lien par Ørsted en 1820 effectuant une démonstration de la pile de Volta.

Expérience d'Ørsted : une aiguille aimantée dévie quand elle est à proximité d'un fil conducteur dans lequel circule un courant électrique:

Hans Christian Ørsted (1777-1851) montre que l'aiguille pivote pour s'orienter perpendiculairement au fil, et que l’orientation s’inverse avec le sens du courant. Il montre aussi qu'une bobine de fil se comporte comme un aimant (l'une des faces est un pôle nord, l'autre un pôle sud). Il publie (en latin) ses résultats le 21 juillet 1820, et ils sont présentés à Paris à l'Institut dès le 11 septembre. André Marie Ampère (1775-1836), qui assiste à la séance, effectue alors une série d'expériences et présente une communication dès la séance suivante, le 18 septembre. Il confirme les résultats d'Ørsted, et il annonce que les courants s’attirent comme des aimants (attraction si ↑↑ répulsion si ↑↓) avec une force proportionnelle à l'intensité de chaque courant et inversement proportionnelle à la distance séparant les fils.

Ampère en déduit que les aimants ne sont pas autre chose que des (boucles de) courants électriques, microscopiques. C'est une alternative à l'existence de charges magnétiques (monopôles) et explique pourquoi il y a toujours deux pôles à un aimant. Il indique aussi que l'inversion de la déviation de la boussole par inversion du sens du courant permettrait la transmission de signaux, l'aiguille détectant le passage d'un courant, et son sens. Mais les premiers télégraphes électriques sont dûs à Gauss et Weber, qui relient en 1834 leur laboratoire de Göttingen à l'observatoire, et à Samuel Morse qui relie la même année Washington à Baltimore.

Après l'introduction par Faraday de la notion de champ, on admet

- qu'un courant I crée à distance d un champ (ou induction) magnétique B ∝ I / d perpendiculaire à la direction du courant

- que ce champ magnétique crée une force F = q v ⨉ B (force de Lorentz) sur des charges q se déplaçant à la vitesse v

- et qu'un courant électrique n'étant rien d'autre que des charges en mouvement (Weber), cette force attire ou repousse le fil où circule le 2° courant

L'intensité d'un courant est mesuré en coulombs/seconde ou ampères (1 A provoque une force de 2*10-7 N/m entre deux conducteurs séparés de 1 m) et un champ magnétique en teslas. Un courant de 50 A (tel que peut le fournir une pile de Volta dont la tension est de l'ordre du… volt) engendre donc un champ magnétique de 10-4 T à une distance de 10 cm. En comparaison le champ magnétique terrestre a une intensité de 5*10-5 T, et un tel courant n'a donc aucun mal à dévier l'aiguille d'une boussole, ce qui explique l'expérience d'Ørsted.

Maxwell

Première équation : la divergence du champ électrique est due à la présence d'une charge électrique

Deuxième équation: la divergence du champ magnétique est toujours nulle car il n'existe pas de charge magnétique (monopôle magnétique), loi de Gauss.

Troisième équation: le rotationnel du champ électrique est engendré par une variation dans le temps du champ magnétique, loi de Faraday de l'induction

rotationnel

rotationnel

Quatrième équation: le rotationnel du champ magnétique est engendré par une variation temporelle du champ électrique ou par un courant électrique, loi d'Ampère

Lumière

Conséquence des équations de Maxwell: la lumière est une onde électromagnétique, un champ électrique et un champ magnétique transverses et variables:

Mais la théorie de Maxwell ne permet pas d’expliquer les spectres, ni les spectres continus de la lumière émise par des corps chauffés, ni les spectres de raies de la lumière émise par la matière excitée par des courants électriques. Pourtant Helmholtz s'était efforcé en 1881, sans grand succès, d'expliquer la dispersion de la lumière par son interaction électromagnétique avec des particules massives électriquement chargées, mises en oscillation par le champ électromagnétique. Et l'idée que les spectres résultaient de l'oscillation de charges à l'échelle atomique se répandait. Maxwell pensait même que les particules de sa théorie cinétique des gaz n'étaient pas les atomes mais des objets plus gros, dotés d'une structure interne qui puisse être responsable des raies. L'explication de la largeur de ces raies comme conséquence de l'effet Doppler due à la dispersion des vitesses des molécules conduisait à des vitesses en bon accord avec la théorie cinétique des gaz. Les physiciens pensaient donc être sur la bonne voie, même s'ils ne parvenaient pas à expliquer l'existence même des raies. Ni d'ailleurs le spectre thermique ("catastrophe ultraviolette"). Et pas non plus l’effet photoélectrique.

Alors?

Les atomes existent-ils vraiment? Indications nombreuses

- interprétation simple de la loi des proportions définies, de la loi des proportions multiples, de la loi des gaz parfaits…

- interprétation simple des réactions chimiques, des isoméries et des allotropies

- explication de la thermodynamique par la théorie cinétique des gaz

La chimie continuait à se développer, et à devenir de plus en plus prédictive, introduisant la notion de valence vers 1860, puis de carbone tétravalent, la notion de radical et de groupes comme le radical méthyle CH3 ou le radical éthyle C2H5 s'ajoutant en bloc à une molécule pour lui conférer de nouvelles propriétés. Les notions d'acide et de base se précisèrent.

Mais rien de tout ceci n'impliquait l'existence réelle, physique des atomes, qui pouvaient n'être qu'une manière mnémotechnique de retrouver quelles réactions étaient ou non possibles, et de préciser les masses requises et les masses produites. Les chimistes "positivistes" utilisaient un "atomisme chimique" plus proche des minima naturalia que des atomes de Dalton, sans connexion entre propriétés chimiques et arrangements spatiaux de petits objets. Les physiciens calculaient des enthalpies et des chaleurs de réaction, ce qui ne nécesaitait pas de croire en l'existence d'atomes, pour prédire les réactions possibles et leurs vitesses, ce que la théorie atomique était alors incapable de faire (elle ne pouvait pas prédire les affinités)

En l'absence de preuve directe de l'existence des atomes, il était encore parfaitement possible en 1900 de décrire toute la physique et la chimie par des quantités continues ➛ refus de l’atomisme comme hypothèse inutile, et peut-être même risquée, par les énergétistes et équivalentistes (Duhem, Mach, Helmholtz, Planck, Berthelot, Dumas, Ostwald, Rankine…)

Mouvement brownien

Lucrèce (~60 av. JC) décrit la danse de la poussière dans un rai de lumière, en laquelle il voit une preuve de l’existence des atomes (en fait non: microturbulences)

Robert Brown (1827) décrit l'agitation incessante de grains de pollen dans l’eau, et il montre qu'elle n'est pas due à des micro-organismes vivants.

SImulation du mouvement d'un corps de taille importante (en jaune) déplacé par des collisions incessantes de corps invisibles (ici en noir) de très petite taille

Suite des positions successives d'un fragment de grain de pollen dans l'eau.

Albert Einstein (1905)

Le mouvement brownien est explicable par des collisions avec des corpuscules (atomes, molécules…), ce que d'autres avaient déjà proposé mais sous forme qualitative. Einstein propose un modèle dans lequel le déplacement est relié aux propriétés physiques des corpuscules → taille et nombre de ces corpuscules → nombre d’Avogadro

Jean Perrin (1909) vérifia expérimentalement les prédictions de ce modèle (et de variantes proposées)

Mouvement brownien mesuré par Jean Perrin (Les atomes 1913)

⇒ les atomes existent réellement

… mais ils ne sont pas insécables!

La découverte de l'électron et de la radioactivité

Joseph John Thomson observa en 1897 la déviation des rayons cathodiques par des champs électrique et magnétique, lui permettant de calculer le rapport masse/charge électrique de ce qui est dévié ⇒ 1/2000 de celui des ions hydrogène ⇒ électron = corpuscule très léger ⇒ particule subatomique

À la suite d ela découverte des rayosn X en 1895 par Wilhelm Röntgen, Henri Becquerel découvrit en 1896 l'émission de rayonnement par l’uranium. Ernest Rutherford distingua en 1898 deux types de rayonnement, qu'il appela α et β. Pierre et Marie Curie découvrirent en 1898 deux nouveaux corps, le polonium et le radium, uniquement grâce à leur radioactivité. Rutherford établit ensuite que certains atomes se transformaient en d’autres (⇒ les atomes ne sont pas immuables), puis en 1911 que l’atome était formé d’un très petit noyau compact entouré d’électrons, et enfin en 1920 que le noyau était lui-même formé de protons (=noyau de l’hydrogène) et d’électrons, avant que la découverte des neutrons en 1932 aboutisse à l'image d'un noyau assemblage de neutrons et de protons.